بررسی چالشها و فرصت های هوش مصنوعی در کسب و کار را با چند سوال آغاز میکنیم:

• کسب و کارها برای اجرای هوش مصنوعی با چه فرصتها و چالشهایی روبرو هستند؟

• آیا از بکارگیری فناوریهای هوش مصنوعی در کسب و کار خودتان تردید دارید؟

• هوش مصنوعی چه تاثیری روی رشد و سودآوری کسب و کار شما گذاشته است؟امروزه حتی انسانهای عادی نیز به درک قابلیتهای هوش مصنوعی رغبت نشان میدهند. دلیل چنین تمایلی را میتوان در این امر جستجو کرد که هوش مصنوعی تمامی جنبههای زندگی ما را تحتالشعاع قرار داده است. ظاهراً این فناوری توانسته اشتیاق و تردید را به طور همزمان در انسانها برانگیزد. البته معیارهای مختلفی در آن دخیل است! حال بیایید آمار و حقایق مربوط به هوش مصنوعی را بررسی کنیم:• فناوری هوش مصنوعی میتواند بهرهوری کسب و کار را تا ۴۰ درصد افزایش دهد (منبع: Accenture).

• تعداد استارتآپهای هوش مصنوعی از سال ۲۰۰۰ به میزان چهارده برابر افزایش یافته است (Forbes).

• هوش مصنوعی باعث خواهد شد ۱۶ درصد از مشاغل در آمریکا توسط ماشینها انجام شود (Forrester).

• ۱۵ درصد کسب و کارها از هوش مصنوعی استفاده میکنند. ۳۱ درصد از کسب و کارها اعلام کردهاند که بکارگیری هوش مصنوعی تا ۱۲ ماه آینده در دستور کارشان قرار دارد (Adobe).کاملاً مبرهن است که هوش مصنوعی فقط به آزمایشگاههای نوآوری محدود نمیشود. این فناوری به دلیل قابلیت بالایی که در متحول ساختنِ کسب و کارها دارد، تحسین همگان را برانگیخته است. با این حال، کسب و کارها پیش از آنکه از ظرفیتهای واقعی این فناوری در کسب و کارهایشان بهره گیرند، باید خود را آماده رویارویی با چند چالش نمایند.

بکارگیری هوش مصنوعی در کسب و کار با چالشهای بسیاری همراه است.

۱. محاسبه یا رایانش چندان پیشرفته نیست!

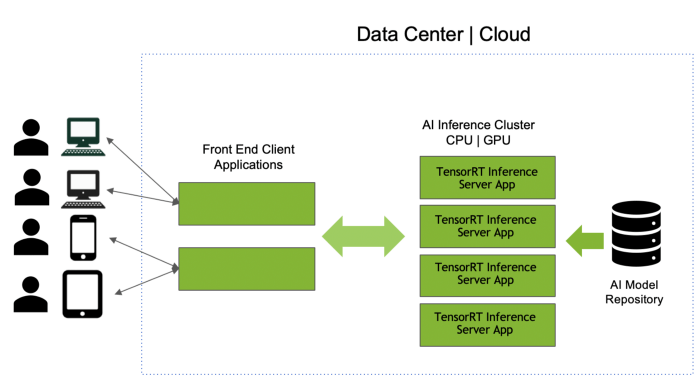

روشهای یادگیری عمیق و یادگیری ماشین در نگاه اول از فواید بسیاری برخوردارند، اما برای اینکه سرعت عمل بالایی داشته باشد، باید یک سری محاسبات را پشت سر بگذارند. کاملاً مشهود است که این روشهای هوش مصنوعی به قدرت پردازش قابل ملاحظهای نیاز دارند. هوش مصنوعی برای چندین سال در محافل علمی و تخصصی مورد بحث و بررسی قرار گرفته است. همواره محققان و کارشناسان این مسئله را به پیش کشیدهاند که کماکان قدرت لازم برای اجرای این قبیل از روشهای هوش مصنوعی در دسترس نیست. رایانش ابری و سیستمهای پردازش موازی در کوتاهمدت این امیدواری را در دل همگان ایجاد کردهاند که اجرای روشهای مصنوعی سرانجام میتواند با موفقیت همراه باشد؛ اما با افزایش حجم دادهها و ایجاد الگوریتمهای فوقالعاده پیچیده توسط روشهای یادگیری عمیق، نمیتوان فقط به رایانش ابری دل بست.

| فواید احتمالی هوش مصنوعی | چالشها و ریسکهای هوش مصنوعی |

• انجام کارهای تکراری و ملالآور

• انجام کارهای پیچیده، تنها در کسری از ثانیه

• تولید نتایج قابل درک

• بکارگیری ماشینهای هوش مصنوعی در محیطهای خطرناک و کاهش خطرات جانی برای انسانها

• ایفای نقش مکمل در انجام امور

• قابل اطمینانتر بودن سیستمهای هوش مصنوعی نسبت به انسان

| • توسعه آن دسته از سیستمهای هوش مصنوعی که قدرت تفکر دارند، در حال حاضر کار دشواری است.

• استفاده وسیع از هوش مصنوعی باعث بروز یک سری مسائل اخلاقی و حقوقی شده است. تلاشها برای رفع این مسائل کماکان ادامه دارد.

• فقط مالکان سرمایههای عظیم از مزایا و منافع فناوریهای هوش مصنوعی بهرهمند میشوند.

• تاثیر منفی روی مهارتهای سنتی و افزایش نابرابری |

۲. حمایت مردمیِ ناچیز

موارد استفاده از هوش مصنوعی در بازار اندک است. به عبارت دیگر، سازمانهای انگشتشماری به سرمایهگذاری در توسعه محصولات هوش مصنوعی ابراز علاقه کردهاند. افزون بر این، سایر کسب و کارها نمیتوانند این واقعیت را بپذیرند که جهان با سرعت قابل ملاحظهای به سوی ماشینی شدن پیش میرود و نباید از این قافله عقب ماند. عده بسیار اندکی میدانند که ماشینها چگونه فکر کرده و خودشان اقدام به یادگیری میکنند. در همین راستا، میتوان پلتفرمها و ابزارهایی را به کار بست که زمینه را برای انجام کارهای هوش مصنوعی در قالب خدمات فراهم میکنند. سازمانها به جای اینکه همه کارها را از صفر شروع کنند، میتوانند از راهحلهای آماده استفاده کنند.

۳. اعتمادسازی

یکی از مشکلات هوش مصنوعی این است که همه آن را به عنوان جعبه سیاه در نظر میگیرند. وقتی افراد از نحوه تصمیمگیری سر در نیاورند، احساس راحتی نمیکنند. برای نمونه، بانکها از الگوریتمهای سادهای استفاده میکنند که بر پایه ریاضی خطی است. بنابراین، میتوان الگوریتم و چگونگی ارائه واکنش از ورودی تا خروجی را به راحتی توضیح داد. متاسفانه، هوش مصنوعی در امرِ اعتمادسازی عملکرد درخشانی نداشته است. تنها راهحل ممکن برای این مشکل این است که کارآیی این فناوری برای افراد نشان داده شود. با این حال، واقعیت قدری متفاوت است. فرصتهای فراوانی برای بهبود وضعیت وجود دارد . پیشبینیهای دقیق هوش مصنوعی میتواند نقش بیبدیلی در تحقق این امر داشته باشد. البته این مورد به مذاق دولتها خوش نخواهد آمد. قانونی را تصور کنید که این حقوق را به افراد اعطا میکند تا با تکیه بر هوش مصنوعی، درباره تصمیمات اتخاذ شده توسط دولت از او توضیح بخواهند.

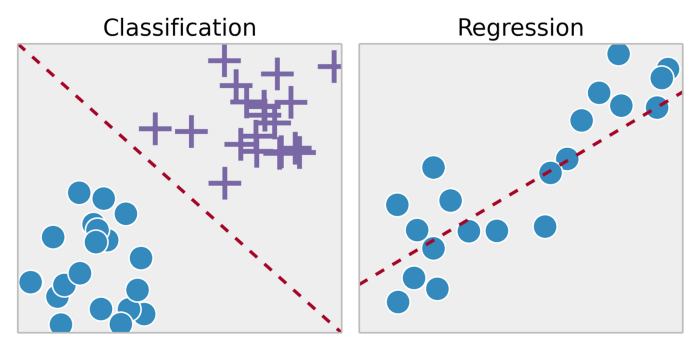

۴. تفکر یکبعدی

یکی از مسائل بزرگی که باید مد نظر قرار داد این است که اکثر موارد استفاده از هوش مصنوعی جنبه تخصصی دارند. هوش مصنوعی تخصصی با عنوان «هوش مصنوعی کاربردی» نیز شناخته میشود. هوش مصنوعی کاربردی فقط برای انجام یک کار ساخته شده و در انجام همین کار سعی میکند بهتر و بهتر شود. هوش مصنوعی در این فرایند به ورودیها ارائه شده و نتایج بدست آمده توجه میکند. لذا بهترین نتایج را مورد بررسی قرار داده و مقادیر ورودی را یادداشت میکند. هوش مصنوعی تعمیمیافته جنبههای متفاوتی را در برمیگیرد و توان انجام امور مختلفی را دارد. اما برای تحقق این اهداف باید صبر کرد. سیستمهای هوش مصنوعی باید به گونهای آموزش داده شوند که از بروز مشکلات دیگر توسط آنها اطمینان حاصل گردد.

۵. قابلیت اثبات

سازمانهایی که محصولات هوش مصنوعی را در دستور کارشان قرار دادهاند، نمیتوانند به روشنی درباره چشماندازها و دستاوردهایشان به کمک روشهای هوش مصنوعی سخن بگویند. افراد کماکان درباره چگونگی اتخاذ تصمیم توسط این فناوری با دیدۀ تردید مینگرند؛ این مسئله در اذهان عمومی هست که آیا تصمیمات هوش مصنوعی همگی بیعیب و نقص است یا خیر. سازمانها در حال حاضر با آغوش باز به استقبال پیشبینیهای هوش مصنوعی نمیروند و جانب احتیاط را در این خصوص رعایت میکنند. سازمانها با اِثبات این قضیه مشکل دارند که فرایند تصمیمگیری سیستمهای هوش مصنوعی بی هیچ عیب و نقصی پیش میرود. باید هوش مصنوعی قابل تبیین، قابل اثبات و شفاف باشد. سازمانها باید آن دسته از سیستمهای هوش مصنوعی را به کار گیرند که قابل تبیین باشد.

۶. امنیت و حریم خصوصی دادهها

سیستمهای هوش مصنوعی عمدتاً به حجم قابل ملاحظهای داده برای یادگیری و اتخاذ تصمیمهای هوشمندانه نیاز دارند. سیستمهای یادگیری ماشین به داده وابستهاند؛ داده نیز غالبا! ماهیت حساس و فردی دارد. این سیستمها از روی داده اقدام به یادگیری کرده و خود را ارتقاء میبخشند. به دلیل این نوع یادگیری سیستماتیک، این سیستمهای یادگیری ماشین در معرض سرقت هویت و نقض داده قرار میگیرند. اتحادیه اروپا قانونی تحت عنوان «قانون عمومی محافظت از اطلاعات» تصویب کرده تا از محافظت کامل از دادههای فردی اطمینان حاصل کند. این اقدام بلافاصله پس از افزایش آگاهی افراد درباره طیف فزایندۀ تصمیمات ماشین به انجام رسید. علاوه بر این، روش منحصربفردی موسوم به یادگیری فدراسیونی وجود دارد که سعی در مختل کردن پارادایم هوش مصنوعی دارد. یادگیری فدراسیونی دانشمندان داده را ترغیب میکند تا سیستمهای هوش مصنوعی را بدون تحت تاثیر قرار دادنِ امنیت داده کاربران بسازند.

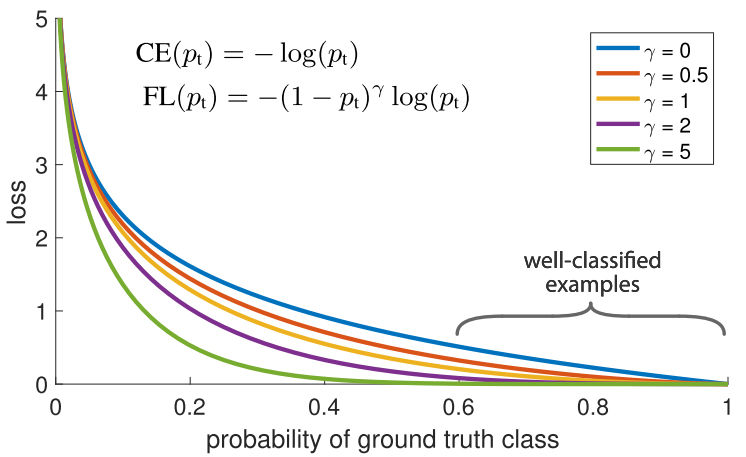

۷. سوگیری الگوریتم

یکی از مسائل بزرگی که سیستمهای هوش مصنوعی با خود به همراه دارند این است که میزان خوب یا بد بودنشان به حجم دادههایی بستگی دارد که با آنها آموزش دیدهاند. دادههای بد دارای سوگیریهای نژادی، جنسیتی، قومیتی و … هستند. الگوریتمهای اختصاصی کاربردهای مختلفی دارند که از جمله آنها میتوان به این موارد اشاره کرد: چه کسی بسته مالی ارائه کرد؟ چه نهادی به اعطای وام پرداخته است؟ و … اگر سوگیری به صورت پنهان در الگوریتم باقی بماند و تصمیمهای حیاتی را تحتالشعاع قرار دهد، میتوان انتظار داشت که نتایج غیراخلاقی و غیرمنصفانه به بار آید. کارشناسان بر این باورند که این سوگیریها در آینده افزایش خواهد یافت زیرا سیستمهای هوش مصنوعی کماکان به استفاده از دادههای بد ادامه میدهند. بنابراین، سازمانهایی که هوش مصنوعی را در محوریت کارهای خود قرار دادهاند، باید این سیستمها را به کمک دادههای بدون سوگیری آموزش دهند و الگوریتمهایی را بسازند که به راحتی قابل توضیح باشند.

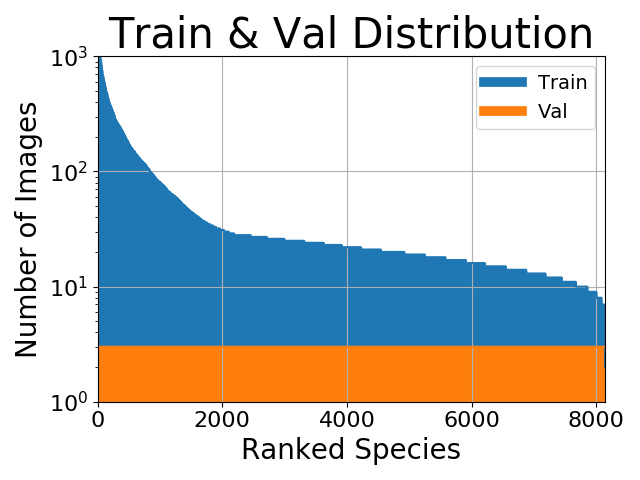

۸. امنیت داده

این واقعیت غیرقابل انکار است که امروزه سازمانها به حجم بسیار بالایی از دادهها نسبت به گذشته دسترسی دارند. با این حال، دیتاستهایی که در نرمافزارهای هوش مصنوعی با هدف یادگیری به کار برده میشوند، خیلی نادر هستند. این نوع یادگیری مستلزم دادههای برچسبدار میباشد. دادههای برچسبدار ساختاریافته هستند و ماشینها به راحتی میتوانند از آن دادهها برای یادگیری استفاده کنند. علاوه بر این، دادههای برچسبدار محدودیت دارند. احتمال میرود ساخت خودکار الگوریتمهای پیچیده در آینده به وخامت این مسئله بیفزاید. خوشبختانه، کماکان بارقهای از امید وجود دارد. سازمانها در حال سرمایهگذاری بر روی روشهای طراحی هستند و علیرغم کمیاب بودن دادههای برچسبدار، تمرکزشان را روی مدلهای هوش مصنوعی معطوف ساختهاند.

فرصت های هوش مصنوعی در حوزه کسب و کار

بکارگیری سیستمهای هوش مصنوعی در حوزه کسب و کار با ریسکها و چالشهای بسیاری همراه است. اما مثل دو روی متفاوت سکه، هوش مصنوعی میتواند فرصتهای متعددی برای کسب و کارها به ارمغان آورَد. به لطف فرصتهایی که هوش مصنوعی پدید آورده، توسعهدهندگان کاربلد هندی در بسیاری از کسب و کارها استخدام میشوند تا نرمافزارهای هوش مصنوعی اختصاصیشان را ایجاد کنند. بگذارید تکتک این موارد را بررسی کنیم.

۱. هوش مصنوعی در بازاریابی

همه کسب و کارهای کوچک رویایِ کاهش بودجه بازاریابی و تمرکز بر روی راهبردهای کارآمدِ بازاریابی را در سر میپرورانند. علاوه بر این، شرکتها راغب هستند بدانند کدام فعالیتهای بازاریابی بیشترین سودآوری را به همراه دارد. اما تجزیه و تحلیل دادهها در میان همه کانالهای رسانهای کار دشواری است و زمان بسیاری را میطلبد. اینجاست که هوش مصنوعی به ارائه راهحلهای بازاریابی میپردازد! پلتفرمهای هوش مصنوعی از قبیل Acquisio نقش بسیار مهمی در مدیریت عملیات بازاریابی دارند؛ به ویژه در کانالهای گوناگونی نظیر Google Adwords، فیسبوک و Bing.

۲. استفاده از روشهای هوش مصنوعی برای ردیابی رقبا

همیشه باید بدانید رقبایتان در چه وضعیتی به سر میبرند و چه سیاستهایی در پیش گرفتهاند. شوربختانه، اکثر مالکان کسب و کارها به دلیل مشغله کاری بسیار بالایی که دارند، به مقوله رقابت رسیدگی نمیکنند. آنها معمولاً از فعالیتهای رقبای خود اطلاعات چندانی در اختیار ندارند. اما میتوان از هوش مصنوعی برای انجام چنین کارهایی کمک گرفت. ابزارهای تحلیل رقابت گوناگونی وجود دارد که از جمله آنها میتوان به Crayon اشاره کرد. این ابزارها با تکیه بر کانالهای مختلفی مثل وبسایتها، شبکههای اجتماعی و نرمافزارها به ردیابی و بررسی وضعیت رقبا میپردازند. علاوه بر این، ابزارهای مذکور این فرصت را در اختیار مالکان کسب و کارها میگذارند تا تغییرات موجود در برنامهریزی بازاریابی رقبا را با دقت بالایی زیر نظر داشته باشند.

۳. بررسی سریع کلان دادهها

اصلاً جای تعجب نیست که مالکان کسب و کارهای کوچک تمایل بالایی به استفاده از حجم قابل ملاحظهای از اطلاعات آنلاین و آفلاین دارند. این اطلاعات به کسب و کارها کمک میکنند تا تصمیمهای مهمی در راستای رشد و توسعه خود اتخاذ نمایند. مهمترین نکته در خصوص بکارگیری ابزارهای هوش مصنوعی در حوزه کسب و کار این است که آنها در تمامی فرایندهای دادهسازی قابلیت کاربرد دارند و میتوانند به بینشهایی ختم شوند که عملاً به کار میآیند. ابزارهای کسب و کار هوش مصنوعی مثل Monkey Learn به یکپارچهسازی و تحلیل دادهها در کانالهای گوناگون پرداخته و باعث صرفهجویی در زمان میشوند.

۴. راهحلهای حمایت از مشتری بر پایه هوش مصنوعی

سیستمهای چت خودکار این فرصت را در اختیار کسب و کارهای کوچک قرار میدهند تا فعالیتهای خدمترسانی به مشتریان را زیر نظر گرفته و منابع لازم برای تعاملات دشوار مشتری را در خود توسعه دهند. آن دسته از ابزارهای خدمترسانی به مشتریان که بر پایه سیستمهای هوش مصنوعی قرار دارند (مثلDigitalGenius یا ChattyPeople)، فرایند پاسخگویی به پرسشهای مشتریان و طبقهبندی بلیطها یا پیامرسانی مستقیم به بخش مربوطه را تسهیل میکنند. بکارگیری هوش مصنوعی در بخش حمایت از مشتریان باعث صرفهجویی در زمان میشود.

۵. هوش مصنوعی در حوزه «مدیریت روابط مشتریان»

چه احساسی به شما دست میدهد اگر بتوانید در مدیریت روابط خود با مشتریان گام مهم و رو به جلویی بردارید و بینش مفیدی درباره چگونگی تعامل با مشتریان فعلی و آتی کسب کنید؟ آن دسته از پلتفرمهای CRM که از هوش مصنوعی بهره میبرند، قابلیت تحلیل داده دارند. این پلتفرمها بر اساس دادههای مشتریان و فرایندهای کسب و کار منحصربفرد شرکت به پیشبینی و حتی توصیه میپردازند.

{“type”:”block”,”srcIndex”:1,”srcClientId”:”da42a25a-25da-44bb-a5c7-df86f727b6b9″,”srcRootClientId”:””}

نتیجهگیری

در این مقاله فهمیدیم که گویا سرانجام نوبت هوش مصنوعی فرا رسیده، اما هنوز جا برای پیشرفت وجود دارد. شرکتها و سازمانهای مختلف به طور غیریکنواخت از هوش مصنوعی استفاده میکنند. علاوه بر این، مقاله حاضر به بررسی فرصتها و چالشهایی پرداخت که اجرای هوش مصنوعی به همراه دارد. حال، امیدواریم به دید روشنی در خصوص توسعه هوش مصنوعی در شرکت خود دست یافته باشید. موفق باشید!

منبع: hooshio.com