دیوید فروچی کامپیوتری ساخت که در مسابقه تلویزیونی Jeopardi! پیروز شد! از آن زمان به بعد، فروچی وقت خود را صرف پرداختن به مسئلهای چالش برانگیزتر کرده است.دیوید فروچی، سازنده واتسون – ماشینی که به IBM تعلق دارد و Jeopardy! بازی میکند- برای ماشینی که به تازگی ساخته است، داستانی کودکانه تعریف میکند.

در این داستان، فرناندو و زویی چند گیاه میخرند. فرناندو گیاه خود را لب پنجره میگذارد و زویی گیاه خود را در یک اتاق تاریک میگذارد. پس از گذشت چندین روز، گیاه فرناندو سبز و شاداب است اما برگهای گیاه زویی زرد شدهاند. زویی گیاه خود را به لب پنجره منتقل میکند و گیاه او هم رشد میکند و شاداب میشود.

یک سؤال بر روی صفحه نمایش مقابل فروچی ظاهر میشود: «آیا فرناندو برای اینکه میخواهد گیاهش سر سبز و شاداب شود، آن را لب پنجره میگذارد؟ از پنجره نور خورشید به داخل میتابد و گیاه باید شاداب و سرسبز باشد.

سیستم هوش مصنوعی فروچی با پرسیدن این سؤال قصد دارد ساز و کار دنیای پیرامون خود را یاد بگیرد. بیشک من و شما میدانیم چرا فرناندو گیاه خود را لب پنجره گذاشته است. اما درک این موضوع برای سیستم هوش مصنوعی به طور شگفتانگیزی دشوار است.

فروچی و شرکت وی موسوم به Elemental Cognition قصد دارند به ماشینها آموزش دهند دانش روزمرهای که امکان برقراری ارتباط، استدلال و گشتوگذار در محیط پیرامون را برای انسانها فراهم میکند، کسب کنند و آن را به کار ببندد و امیدوارند از این طریق بتوانند نواقص و کاستیهای هوش مصنوعی کنونی را برطرف کنند. استفاده از استدلال عقلانی به حدی برای انسانها آسان است و به صورت مکرر از آن استفاده میکنند که به ندرت متوجه وجود چنین چیزی میشوند.

ارنست دیویس ، یکی از اساتید دانشگاه نیویورک که چندین دهه از عمر خود را صرف مطالعه بر روی این مسئله کرده، معتقد است عقل سلیم برای پیشرفت و ترقی هر چیزی از زبان گرفته تا روباتیک لازم و ضروری است. به گفته وی عقل سلیم «در مرکز اکثر کارهایی قرار دارد که میخواهیم با هوش مصنوعی انجام دهیم.»

دیویس معتقد است برای آنکه ماشینها بتوانند هوشمندی حقیقی و جامعی داشته باشند باید مفاهیم پایهای همچون زمان، رابطه علت و معلولی و تعامل اجتماعی را فرا بگیرند. به عقیده وی «این مانع بزرگی است که رویکردهای کنونی مشکلات جدی با آن دارند.»

تازهترین موج پیشرفت در زمینه هوش مصنوعی که در نتیجه ادغام یادگیری ماشین و کلانداده حاصل شده، گجتهایی را برای ما به ارمغان آورده که به دستورات و فرامین صوتی پاسخ میگویند و منجر به ساخت نمونههایی از ماشینهای خودران شده که میتوانند اشیای حاضر مسیر پیشرو را تشخیص دهند. تمامی پیشرفتهایی که در این زمینه حاصل شده خارقالعاده هستند اما از عقل سلیم برخوردار نیستند. اَلِکسا و سیری با بهرهگیری از ویکیپدیا میتوانند اطلاعاتی در مورد گونهای گیاه در اختیار شما قرار دهند اما هیچ کدام نمیدانند اگر گیاهی را در یک اتاق تاریک بگذارید، چه اتفاقی میافتد. برنامهای که آموزش میبیند تا موانع موجود در جاده را تشخیص دهد، به طور معمول نمیداند چرا ممانعت از تصادف با عابرین مهمتر از گیر نکردن در ترافیکهای سنگین است.

آیا روزی فرا میرسد که ماشینها بتوانند چیزهایی که میخوانند را درک کنند؟ تحقق این هدف کار دشواری است.

-دیوید فروچی، Elemental Cognition

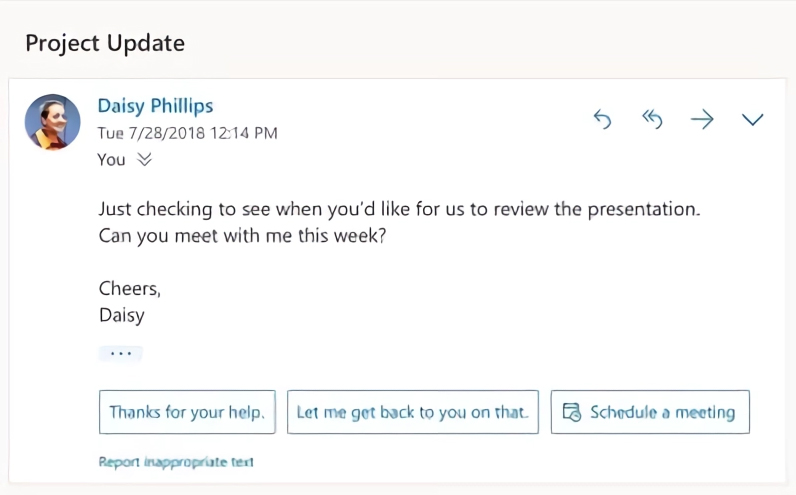

دوباره به داستان کامپیوتر فروچی برمیگردیم. پژوهشگر در پاسخ به سؤالی که سیستم راجع به گیاه فرناندو پرسیده بر روی گزینه «بله» کلیک میکند. در جایی از سِرور، یک برنامه هوش مصنوعی به نام CLARA این اطلاعات را به کتابخانه حقایق و مفاهیم – نوعی دانش عقل سلیم مصنوعی- اضافه میکند. CLARA شبیه به کودکی که کنجکاویاش پایانی ندارد، به صورت مکرر از فروچی سؤالاتی راجع به داستان گیاه میپرسد و تلاش میکند سازوکار محیط پیرامون را «درک کند». CLARA مخفف واژه Collaborative Learning and Reading Agent است. سؤالی که فروچی مطرح میکند این است که « آیا روزی فرا میرسد که ماشینها بتوانند چیزهایی که میخوانند را درک کنند؟»، وی در ادامه میگوید « تحقق این هدف کار دشواری است و البته هدف نهایی Elemental Cognition هم همین است.»

فروچی از مدتی قبل به مطالعه و بررسی این مشکل پرداخته است. یک دهه قبل، زمانیکه فروچی پروژه توسعه واتسون، متعلق به IBM، را رهبری میکرد، توسعه و ساخت کامپیوتری که بتواند به سؤالات مسابقه Jeopardy! پاسخ دهد، امری غیرممکن به نظر میرسید. با این حال، واتسون توانست در سال ۲۰۱۱ چندین نفر از برندگان این مسابقه تلویزیونی که تبلیغات زیادی راجع به آن شده بود را شکست دهد. واتسون حجم بالایی از متون را تجزیه و تحلیل میکند تا اطلاعات مهم نهفته در جزئیات پیشپاافتاده که دربردارنده پاسخ سؤالات مسابقه Jeopardy! هستند را پیدا کند. برندهشدن در این مسابقه دستاورد بزرگی برای هوش مصنوعی بود اما عدم درک کامل و صحیح هوش مصنوعی از مسائل و موضوعات نیز به وضوح آشکار بود. برای مثال، این ماشین در پخش زنده، یکی از سؤالات مربوط به بخش «شهرهای آمریکا» را با «تورونتو چیست » پاسخ داد.

به گفته فروچی نواقص و کاستیهای واتسون و گزافهپردازیهای رسانهها راجع به این ماشین، او را بر آن داشته تا ماشینهایی بسازد که درک بهتری از دنیا و محیط پیرامون داشته باشند. از آن زمان به بعد IBM واتسون را به یک برند تجاری تبدیل کرده که به انواع گوناگونی از فناوریها اشاره دارد که بسیاری از آنها در توسعه و ساخت ماشین اصلی کاربردی نداشتهاند.

یک سال پس از مسابقه Jeopardy! فروچی از تیم IBM جدا شد تا شرکت Elemental Cognition را تأسیس کند. تا به امروز Bridgewater Associates منابع مالی این شرکت را تأمین کرده است؛ Bridgewater Associates یک صندوق پوشش ریسک است که توسط رِی دالیو ایجاد شده که سرمایهای معادل ۱۶۰ میلیارد دلار و سه حزب دیگر را مدیریت میکند. Elemental Cognition در محوطه Bridgewater واقع شده است؛ Bridgewater در جنگلهای سرسبز وستپورت ، کنتیک واقع شده و منظرهای رو به دریاچه دارد.

مدت زمان کوتاهی پس از پیروزی واتسون تغییر و تحولاتی در حوزه فناوری هوش مصنوعی ایجاد شد. یادگیری عمیق که با تغذیه حجم بالایی از دادهها به کامپیوترها شناسایی چهره، رونویسی گفتار و غیره را آموزش میداد به ابزاری بسیار قدرتمند تبدیل شد و به شیوههای گوناگونی مورد استفاده قرار گرفت.

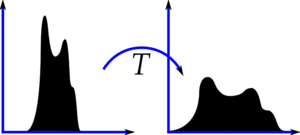

طی دو سال گذشته، یادگیری عمیق در زمینه درک زبان پیشرفتهای چشمگیری داشته است. تغذیه حجم بالایی از متون به نوع خاصی از شبکههای عصبی مصنوعی منجر به ساخت مدلی میشود که میتواند به سؤالات پاسخ دهد و یا متونی ایجاد کند که انسجام بالایی دارند. تیمهای مستقر در Google، Baidu، Microsoft و OpenAI مدلهای بزرگتر و پیچیدهتری ساختهاند که در درک زبان به مراتب عملکرد بهتری دارند.

با این حال این مدلها از عقل سلیم برخوردار نیستند. برای مثال، تیم فروچی داستان فرناندو و زویی را به یک مدل پیشرفته زبان دادند و از او خواستند جمله مقابل را کامل کند: « زویی گیاهش را لب پنجرهای قرار میدهد که از آن نور خورشید به داخل میتابد. به زودی …» این مدل متوجه نشد که نور خورشید برای رشد گیاه لازم است و در نتیجه بر مبنای تطبیق آماری الگوها عبارتهای نامفهومی برای تکمیل جمله ایجاد کرد:« چیزی ناخوشایند پیدا کرد»، « در پنجره کود دیده میشود» و « از اتاق خواب یک گیاه کم شده است.»

به نظر میرسد از نکتهای جدی غافل ماندهایم

-ارنست دیویس، دانشگاه نیویورک

CLARA قصد دارد پا را فراتر از این بگذارد و با بهرهگیری از قوانین منطقی صریح، برای مثال گیاهان برگ دارند و به نور احتیاج دارند، تکنیکهای یادگیری عمیق را با شیوههای قدیمی ماشینها برای فراگیری دانش ترکیب کند. CLARA برای تشخیص مفاهیمی از جمله اسم و فعلهای در جملات از روشهای آماری استفاده میکند. علاوه بر این CLARA دارای قطعاتی به نام «دانش مرکزی » است؛ برای مثال اتفاقات در مناسب روی میدهند و موجب میشوند اتفاقات دیگری روی دهد.

دانش راجع به برخی موضوعات خاص را Mechanical Turkers در اختیار سازندگان CLARA قرار میدهد و سپس آنها دانش کسبشده را به CLARA تغذیه میکنند. برای مثال دانش راجع به موضوعات خاص ممکن است شامل حقایقی از این قبلی باشد: نور به رشد گیاه کمک میکند و وجود پنجره موجب میشود نور خورشید به داخل راه پیدا کند. در مقابل، یک مدل یادگیری عمیق که از دادهها و اطلاعات صحیح تغذیه میشود ممکن است بتواند و یا شاید نتواند به سؤالاتی که راجع به گیاهشناسی پرسیده میشود پاسخ صحیح بدهد.

از آنجاییکه پیش از این نیز افرادی تلاش کردهاند به صورت دستی موتورهای دانش بسازند و تلاش آنها موفقیتآمیز نبوده است، تغذیه تمامی دانش عقل سلیم به سیستم به صورت دستی فرایندی زمانبر خواهد بود. از این روی CLARA حقایقی که به او تغذیه میشود را به مدلهای زبانی یادگیری عمیق ترکیب میکند تا عقل سلیم خود را بسازد. برای مثال، در داستان گیاه فرناندو و زویی، عقل سلیم به CLARA کمک میکند که متوجه شود قرار داشتن در کنار پنجره به رشد و سرسبزی گیاه کمک میکند.

علاوه بر این CLARA از طریق برقراری تعامل و ارتباط با کاربران نیز به عقل سلیم دست پیدا میکند. و در صورتیکه با تناقضی مواجه شود میتواند بپرسد کدام عبارت بیشتر اوقات صحیح است.

به گفته راجر لوی ، یکی از اساتید دانشگاه MIT که در زمینه هوش مصنوعی، زبان و علوم شناختی فعالیت دارد، « این کار اقدامی چالش برانگیز است، اما به عقیده من هدف و رویایی حائز اهمیت است»، « زبان فقط مجموعهای از الگوها و ارتباطات آماری نیست – زبان با معنا و مفهوم و استدلال و عقل سلیم ما از دنیا پیوند دارد.»

تا حدودی به دلیل اینکه Elemental Cognition تا حد زیادی فعالیتهای خود را به صورت محرمانه انجام میدهد کسی نمیداند فروچی تا چه میزان در آموزش عقل سلیم به هوش مصنوعی موفق بوده است. Elemental Cognition اخیراً مقالهای منتشر کرده و در آن اظهار داشته بیشتر تلاشهایی که برای درک ماشینها انجام میشود با شکست مواجه میشود و به همین دلیل باید با تلاشهایی جایگزین شوند که سؤالات مفهومیتری راجع به معنای متن میپرسند جایگزین شوند. Elemental Cognition در این مقاله هیچ کد و یا جزئیاتی راجع به سیستم خود منتشر نکرده است.

مقیاسگذاری این چنین سیستم پیچیدهای فراتر از داستانها و مثالهای ساده به احتمال زیاد با دشواریهایی همراه خواهد بود. به نظر میرسد فروچی به دنبال شرکتی است که منابع مالی زیادی در اختیار داشته باشد و همچنین به کمک تعداد زیادی از کاربران نیاز دارد. اگر مردم به یک موتور جستوجو و یا یک دستیار مجازی کمک کنند تا به عقل سلیم دست پیدا کند، فرایند دستیابی به عقل سلیم تسریع پیدا میکند. یکی دیگر از احتمالاتی که فروچی پیشنهاد میدهد، برنامهای است که از دانشآموزان راجع به متنی که مطالعه کردهاند سؤالاتی میپرسد تا هر دو مطمئن شوند که متن را درست متوجه شدهاند و آن برنامه هم بتواند مبنای دانش خود را شکل دهد.

فروچی گفته « اگر مؤسسهای قصد سرمایهگذاری دارد، من آمادهام که با او وارد مذاکره شوم»، « من در حال حاضر به پول احتیاج ندارم، اما دوست دارم با شرکت دیگری همکاری کنم و یا شرکت دیگری را خریداری کنیم.»

CLARA تنها سیستم هوش مصنوعی دارای عقل سلیم در شهر نیست. یجین چوآ ، یکی از اساتید دانشگاه واشنگتن و یکی از پژوهشگران مؤسسه هوش مصنوعی آلن ، اخیراً توسعه روش دیگری را رهبری کرده، در این روش که COMET نامیده میشود یادگیری عمیق و منطق نمادین در کنار یکدیگر میگیرند. این برنامه هنگام گفتوگو و پاسخدهی به سؤالات نسبت به مدلهای زبانی یادگیری عمیق کمتر سردرگم میشود، با این حال برخی مواقع دچار اشتباه میشود.

چوآ اعلام کرده دوست دارد پیش از هرگونه قضاوتی، نحوه عملکرد داخلی CLARA را ببیند. زمانی که راجع به این برنامه برای او توضیح دادند، گفت: « در سطح بالا منطقی به نظر میرسد». « به عقیده من میتوانند برای این برنامه چندین مثال از اسباببازیها بیاورند، اما باور اینکه این برنامه بتواند عقل سلیم را در هر کاری تعمیم دهد، دشوار است.»

دیویس از دانشگاه نیویورک مطمئن نیست که هوش مصنوعی عقل سلیم برای واتسون آماده باشد. به گمان او، ضروری است پیشرفتهای بنیادی در حوزه ماشینها حاصل شود تا آنها بتوانند بدون تلاش و زحمت، همچون انسانها عقل سلیم را فرا بگیرند. برای مثال، به گفته وی مشخص نیست که ماشینها چگونه میتوانند مفاهیم نامشخص را درک کنند. به گفته دیویس « به نظر میرسد از نکتهای جدی غافل ماندهایم»، « جنبههایی از آن وجود دارد که ما به آنها حتی نزدیک هم نشدهایم.»

منبع: hooshio.com