هر کشوری که پیشرفتهترین فناوری هوش مصنوعی را در اختیار داشته باشد میتواند بر دنیا حکومت کند. هوش مصنوعی مهمترین فناوری قرن بیست و یکم به شمار میرود به همین دلیل باید از برنامهها و فعالیتهای سایر کشورها در حوزه هوش مصنوعی آگاه باشیم.

در مقاله پیش رو جایگاه فناوری هوش مصنوعی را در سطح جهانی بررسی میکنیم و به دنبال آن مسائلی همچون مباحثات سیاسی، دادهها، مسائل اقتصادی، کسبوکارهای نوپا، تأمین مالی، تحقیق و پژوهش و زیرساخت را مورد مطالعه و بررسی قرار میدهیم. در این مقاله مروری اجمالی خواهیم داشت بر ابرقدرتهای کنونی این حوزه یعنی چین و ایالات متحده و در آینده در مقالاتی جداگانه جایگاه و موقعیت فنآوری هوش مصنوعی را در این دو کشور توضیح خواهیم داد. سؤالی که در نهات مطرح میشود این است که بشر چگونه با چالشهای جهانی هوش مصنوعی مقابله خواهد کرد.

سیاستمداران باید توجه بیشتری به فناوری هوش مصنوعی نشان دهند

اولین موج دیجیتالی کردن در حالی بسط و گسترش پیدا کرد که دولتها دخالت و تأثیر چندانی در شکلگیری آن نداشتند. اگرچه طرحهایی در دست اقدام است تا انحصار گوگل شکسته شود ( ایالات متحده و اروپا)، برای مثال کشورهای اروپایی شرکتهای گوگل و فیسبوک را به پرداخت جریمههای نقدی محکوم میکنند، اما سیاستمداران بیش از یک دهه است که از این بازار غافل بودهاند.

برای اولین بار در تاریخ و با در نظر گرفتن اهمیت فنآوری هوش مصنوعی متوجه شدم که دولتهای بسیاری اقدامات، طرحهای ابتکاری و استراتژیهای متعددی در حوزه هوش مصنوعی تدوین کردهاند و این در حالی است که هر کدام از این دولتها اهداف گوناگونی را دنبال میکنند و رویکردهای متفاوتی در این راستا اتخاذ کردهاند.

فناوری هوش مصنوعی مسئلهای است که سیاستمداران و دولتها ناگزیر با آن مواجه هستند و خواهند بود. فناوریهای هوش مصنوعی میتوانند در پیشگیری از تغییرات آبوهوایی و سیاستهای اقتصادی مؤثر واقع شوند. علاوه بر این هوش مصنوعی مدیریت و حاکمیت صنایع داخلی، امنیت و حریم خصوصی شهروندان را تحت تأثیر قرار میدهد.

از این روی ضروری است دولتها استراتژی بلند مدتی برای پایهریزی و توسعه فناوری هوش مصنوعی تدوین کنند. اما تدوین چنین استراتژیای هزینهبر خواهد بود. برای مثال اروپا در تدوین استراتژیهای بلند مدت و استراتژیهای سرمایهگذاری با مشکلاتی مواجه است.

در مقابل کشور چین برنامه مشخصی برای کنترل و نظارت بر فناوری هوش مصنوعی دارد. چین معتقد است فناوری هوش مصنوعی ابزار مهمی برای سیاستهای خارجی قوی، سلطه نظامی، پیشرفت اقتصادی و همچنین کنترل و نظارت بر جمعیت یک کشور است.

ایالات متحده تحقیقات و پژوهشهای بیشماری در حوزه هوش مصنوعی انجام میدهد و از وجود شرکتهای بزرگی همچون گوگل، مایکروسافت، فیسبوک و آمازون بهرهمند است و این در حالی است که هر کدام از این شرکتها در زمینه توسعه فناوری هوش مصنوعی پیشگام هستند.

هرچند دونالد ترامپ تاکنون اقدمات ویژهای در زمینه هوش مصنوعی انجام نداده اما دولت ایالات متحده دههها است که از طریق وزارتخانهها و سرویسهای مخفی خود به تحقیق و پژوهش در زمینه هوش مصنوعی مشغول است و فنآوریهای هوش مصنوعی را در حوزههای گوناگون پیادهسازی و اجرا میکند.

دو کشور کانادا و فلسطین اشغالی از اهمیت یکسانی برخوردار هستند اما نسبت به سایر کشورهایی که بر سر هوش مصنوعی با یکدیگر به رقابت میپردازند، پیشرفتهای کمتری دارند.

فلسطین اشغالی در حوزه فناوری پیشتاز است و تعداد شرکتهای هوش مصنوعی این کشور نسبت به مجموع شرکتهای هوش مصنوعی آلمان و فرانسه بیشتر است ( برای کسب اطلاعات بیشتر به چشمانداز جهانی هوش مصنوعی رجوع کنید). دانشگاههای متعددی در فلسطین اشغالی وجود دارد و علاوه بر این، این کشور به بازارهای سرمایه آسیا و آمریکا دسترسی دارد و با دولت و صنایع نظامی همکاریهای نزدیکی دارد. Intel یکی از شرکتهای این کشور موسوم به Mobileye را به قیمت ۱۵ میلیارد دلار خریداری کرد و این تنها نمونه کوچکی از فضای پویای هوش مصنوعی در فلسطین اشغالی است.

طی ۷ سال گذشته کشور کانادا تا حد زیادی از مزایای فنآوری یادگیری عمیق بهرهمند شده است. جفری هینتون، یان لوگن، یوشیا بنگیومشهورترین پژوهشگران این حوزه هستند. هر سه پژوهشگر مذکور در دورههای مختلف در مؤسسه تحقیقات پیشرفته کانادا مشغول به تحقیق و پژوهش بودهاند. این سه پژوهشگر توانستند از آخرین «زمستان هوش مصنوعی» عبور کنند و از آن زمان به بعد در حال شکلدهی بازار هستند.

کشور کانادا استراتژی مشخصی برای هوش مصنوعی در اختیار دارد و سالها است که به تحقیق و پژوهش، سرمایهگذاری و پیادهسازی و اجرای فنآوریهای هوش مصنوعی مشغول است.

علاوه بر این سه کشور ژاپن، کره و هند نیز پیشنیازهای لازم برای آنکه طی سالهای آتی نقش مؤثری در حوزه هوش مصنوعی ایفا کنند را در اختیار دارند.

برای کسب اطلاعات بیشتر در این زمینه میتوانید گزارش استراتژیهای ملی هوش مصنوعی که توسط Konrad Adenauer Foundation تدوین شده را مطالعه کنید (بخش اول و بخش دوم).

قدرت اقتصادی و فناوری هوش مصنوعی

هرچند وظیفه تدوین و تنظیم ضوابط و مقررات لازم برای تحقیق و پژوهش، تأمین منابع مالی، آموزش، داده و ارتقاء بر عهده دولتها است اما در نهایت این شرکتها هستند که باید فناوری هوش مصنوعی را توسعه دهند و آن را به بازار عرضه کنند.

پیش از هر چیز باید منافع ملی را در نظر گرفت. به بیانی دیگر شرکتهای سراسر دنیا باید در طرحها، تحقیقات و محصولات هوش مصنوعی خود منافع ملی را در نظر بگیرند. به عقیده من گوگل (Alphabet)، آمازون، مایکروسافت رهبری هوش مصنوعی در جهان را در دست دارند. بزرگترین شرکتهای اینترنتی کشور چین موسوم به Alibaba، Baidu و Tencent نیز در این حوزه پیشتاز هستند.

دو نوع شرکت در حوزه هوش مصنوعی فعالیت دارند: شرکتهایی که هوش مصنوعی را توسعه میدهند و آن را به عنوان محصولی بنیادی به فروش میرسانند و شرکتهایی که از هوش مصنوعی در راستای تکمیل زنجیره ارزشی خود استفاده میکنند.

در هر حال هر شرکتی که امروزه مشغول به فعالیت است ناگزیر به استفاده از فناوری هوش مصنوعی است. از یک سو هوش مصنوعی میتواند جایگزین مدلهای کسبوکار موجود شود و از سوی دیگر میتوان از این فنآوری در فرایندهای بیشمار شرکتها از جمله حسابداری، اداره کردن، تولید، بازاریابی، فروش، امور اداری، مدیریت پرسنل و استخدام بهره جست.

در هر حال یکی از اصلیترین انگیزههای استفاده از هوش مصنوعی کاهش هزینهها و به حداکثر رساندن سود است. البته کنترل این فناوری هم مهم است. هوش مصنوعی جایگزین مشاغلی میشود که پیش از این انسانها انجام میدادند. اغلب مواقع پس از آنکه هوش مصنوعی برای مدتی آموزش دید سریعتر، کارآمدتر از انسانها عمل میکند و هزینههای استفاده از آن نیز در مقایسه با انسانها کمتر خواهد بود. انسانها مریض میشوند، به تعطیلات، غذا و خواب نیاز دارند. انسانها نیاز به سرگرمی دارند و استعفا میدهند و یا بازنشسته میشوند. فنآوری هوش مصنوعی میتواند به صورت تمام وقت کار میکند و این در حالی است که نیازی نیست حقوق آن را افزایش داد. هرچه شرکتها بیشتری از فنآوری هوش مصنوعی استفاده کنند، کمتر به نیروهای کار (انسان) نیاز خواهند داشت.

داده یک مزیت رقابتی است

پایه و اساس تمامی فناوریهای هوش مصنوعی داده است. از این روی در بخشهای مختلفی به داده نیاز خواهیم داشت. پیش از هر چیز برای آموزش و تحقیق و پژوهش در زمینه هوش مصنوعی محدودبه داده نیاز داریم. هر چه سطح دیجیتالی بودن مدل کسبوکار شما بیشتر باشد، دادههای بیشتری خواهید داشت. به همین دلیل پیشتازان بازاریابی (گوگل، فیسبوک)، شرکتهای نرمافزاری ( Salesforce، Microsoft) و خردهفروشهای الکترونیک (Zalando، Amazon) سالها است که در حوزه فنآوری هوش مصنوعی فعالیت میکنند.

تعدادی از بانکها نیز سریعاً متوجه اهمیت هوش مصنوعی شدند. از این روی گلدمن ساکسو جی پی مورگانکارمندان زیادی استخدام کردند که همگی در زمینه یادگیری ماشین و علوم داده تخصص دارند و فعالیت میکنند. شرکتهایی که خودشان داده دارند بر سایر شرکتها برتری دارند و میتوانند به مزیت رقابتی بزرگی دست پیدا کنند. شرکتهایی که داده ندارند باید دادهها را جمعآوری، ذخیره و ارزیابی کنند.

مسائل مربوط به داده موجب شده کشورها قوانین مختلفی در زمینه عدم افشای اطلاعات وضع کنند و به همین دلیل اروپا در شرایط نابسامان و نابرابری قرار گرفته است. هدف از تنظیم قانون عمومی عدم افشای اطلاعاتایجاد بازار داخلی داده در اروپا بوده اما در حال حاضر نقطعه ضعف بزرگی برای اروپا است.

ترس از قانون و مقررات تمامی صنایع را فلج میکند. با گفتوگو با درمانگاهها و پزشکان متوجه شدم که صنعت بهداشت و درمان دیگر دادههای خود را با دیگران به اشتراک نمیگذارد. عدم به اشتراکگذاری دادههای پزشکی و درمانی با دیگران به قیمت جان دیگران تمام میشود، چرا که این دادهها برای پژوهش در زمینه سلامتی و الگوریتمهای افزایش طول عمر اهمیتی حیاتی دارند.

عدم قطعیت راجع به دادهها در حال فلج کردن صنعت اروپا است. ترس از مجازات و جریمه موجب شده کسی دادهها را جمعآوری نکند. در عصری که دادهها نقاط قوت ما هستند، کاری کردهایم که دادهها باعت ترس و وحشت دیگران شدهاند.

اروپا مهمترین بازار داده در دنیا است اما ما در حال هدر دادن توانمندیهای خود هستیم. از سوی دیگر چین نقطه مقابل اروپا است. دولت چین به طور فعالانه به تبادل و متمرکزسازی دادهها کمک میکند ( در بخشی که به کشور چین اختصاص دادهام بیشتری راجع به آن توضیح خواهم داد). علاوه بر این شهروندان آزادنه دادههای خود را به اشتراک میگذارند و نگرانی کمتری راجع به این موضوع دارند. در واقع در قرن بیست و یک حریم خصوصی معنایی ندارد. تمامی فعالیتهای دیجیتالی محاسبه و ذخیره میشوند. با این وجود اروپا کماکان راه قدیمی در پیش گرفته است.

کسبوکارهای نوپای هوش مصنوعی غولهای هوش مصنوعی فردا هستند

کسبوکارهای نوپا اهمیت زیادی برای اقتصاد یک کشور دارند چرا که دو عملیات اساسی و ضروری یک زیستبوم را بر عهده دارند. کسبوکارهای نوپا عامل نوآوری و خلاقیت هستند. این شرکتهای جوان معمولاً نسبت به شرکتهای قدیمیتر شجاعت، سرعت و انعطافپذیری بیشتری در تولید و توسعه محصولات جدید دارند. از آنجاییکه معمولاً کسبوکارهای نوپا توسط منابع مالی صندوقهای خطرپذیر و فرشتگان کسبوکارها پشتیبانی و حمایت میشوند، ریسکپذیری بیشتری دارند و انتظار دارند به موفقیتهای بزرگتر و چشمگیری نائل شوند.

هرچند ۹۵ درصد از کسبوکارهای نوپا همان پنج سال اول از بازار خارج میشوند و نمیتوانند به فعالیت خود ادامه دهند اما زیستبوم از مزایای آنها بهرهمند میشود.

شرکتها میتوانند شرکتهای دیگر را به تملک خود درآورند و از این طریق محصولات و نوآوریها و ابتکارات جدیدی به دست آورند. کارفرمایان سابق نیز شغلهای جدیدی پیدا میکنند و دانش خود را منتقل میکنند. از سوی دیگر سرمایهگذاران و بنیانگذاران هم دانش خود را در پروژههای جدید به کار میبندند و در همان حال میتوانند دانش جدید کسب میکنند.

چنانچه شرکتهای جوان بتوانند پنجسال اول را تاب بیاورند منابع مالی آنها ( از سرمایهگذاریهای بذر و عرضه عمومی اولیه) تأمین میشود، استعدادها و نخبگان به سوی آنها جذب میشوند، رشد میکنند و محصولاتی توسعه میدهند که مصرفکنندگان حاضرند هزینه استفاده از آن را پرداخت کنند و در نهایت به یک شرکت تبدیل میشوند. فیسبوک، گوگل، اَپل، آمازون و Uber کار خود را به عنوان کسبوکارهایی نوپا آغاز کردند و امروزه کنترل و رهبری بازار را در دست دارند.

چارلز ادوارد بویمدیر عامل Ronald Berger در کنفرانس ۲۰۱۸ ظهور هوش مصنوعی

اظهار داشت موج بعدی شرکتهای تریلیون دلاری شرکتهایی خواهند بود که در زمینه هوش مصنوعی فعالیت دارند. تحقق این هدف بدون وجود کسبوکارهای نوپا عملی نخواهد شد. به همین دلیل باید افراد و گروهها را به تأسیس کسبوکارهای نوپا تشویق کنیم.

تحقیق و پژوهش اهمیتی بیش از پیش دارد

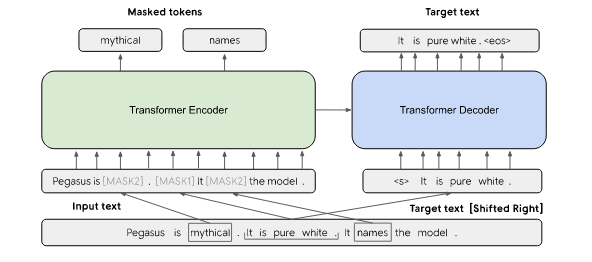

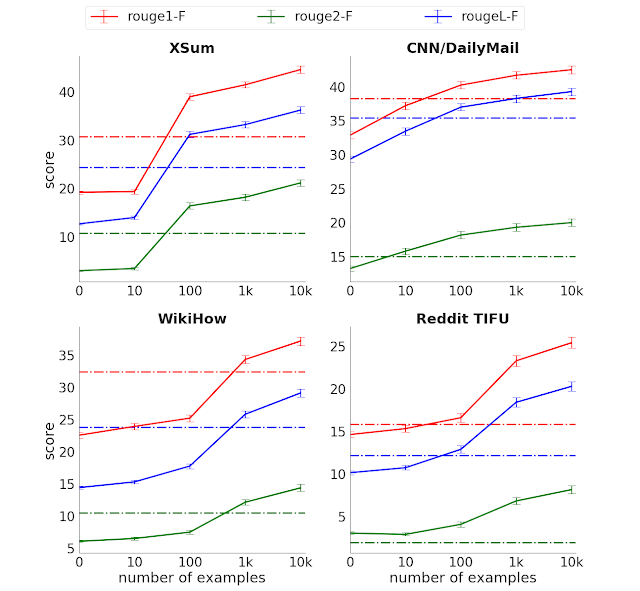

کشف مجدد یادگیری عمیق آغاز راه بود. این حوزه با بهرهگیری از رویکردهای جدید CNN و GAN و الگوریتمهای پیشرفته تکامل پیدا کرد ( سخنرانی علمی پروفسور دامیان بروث در کنفرانس ۲۰۱۷ ظهور هوش مصنوعی مقدمه مناسبی بر یادگیری عمیق است). زبانشناسی محاسباتی پیرامون پردازش زبان طبیعیو تولید زبان طبیعینیز پیشرفتهای چشمگیری را تجربه کرده است.

امروزه و پس از آنکه در سال ۲۰۱۲ توان محاسباتی لازم را کسب کردیم و امکان دسترسی به دادهها برای ما فراهم شد تعداد کثیری از برنامههای کاربردی هوش مصنوعی محدودحاصل نتایج تحقیقات و پژوهشهای سی سال گذشته هستند.

سرمنشأ تحقیقات و پژوهشهای هوش مصنوعی کجاست؟

از یک سو میتوان گفت که سر منشأ این پژوهشها دانشگاهها هستند. دانشگاه اِم آی تی، استنفورد، دانشگاه کارنگی ملونو برکلیپیشتازان تحقیق و پژوهش در زمینه هوش مصنوعی هستند ( برای کسب اطلاعات بیشتر به گزارش AI index که توسط دانشگاه استنفورد گردآوری شده رجوع کنید).

دانشگاه MIT به تنهایی تا سال ۲۰۲۰، ۱ میلیارد دلار در زمینه آموزش برنامههای مدارج جدید هوش مصنوعی سرمایهگذاری خواهد کرد. از سوی دیگر شرکتها نیز به یکی از پیشگامان تحقیق و پژوهش در زمینه هوش مصنوعی تبدیل شدهاند. حتماً اسم DeepMind شرکت گوگل به گوش شما خورده است. شرکت مایکروسافت بیش از ۸۰۰۰ پژوهشگر هوش مصنوعی دارد. افراد نخبه با در اختیار داشتن دادهها و منابع مالی بیشتر تحقیقات و پژوهشهایی برای شرکتها انجام میدهند: ریچارد سوچر

(Salesforce، یان لوکن (فیسبوک)، اندور اِن جی(تا سال ۲۰۱۷ در Baidu) یا دمیس هسابیس

(گوگل).

در مقابل شرکتها و دانشگاههای اروپایی از پیشگامان تحقیق و پژوهش در زمینه هوش مصنوعی نیستند. البته اروپا از وجود افرادی همچون پروفسور یورگن اِشمیتد، پروفسور فرانچسکا روسی و پروفسور هانس اوسکوغیتبهرهمند است.

علاوه بر این در مؤسسه فناوری کارلسروهه، دانشگاه صنعتی مونیخ، دانشگاه صنعتی برلین، دانشگاه استابروک( علوم شناختی)، آکسفورد و دانشگاه کمبریج دورههایی با محوریت هوش مصنوعی برگزار میشود. اما درجه اهمیت تمامی مواردی که به آنها اشاره شد متوسط است و در سطح بینالمللی به عنوان پژوهشهایی با کیفیت بالا شناخته نمیشوند.

در مقابل نمؤسسه تحقیقاتی هوش مصنوعی آلما، چندین مؤسسه ماکس پلانکمؤسسه ماکس پلانکو مؤسسه فرونوفردر آلمان تحقیقات و پژوهشهای کاربردی انجام میدهند. با این وجود حتی این مؤسسات نمیتوانند در رقابت بر سر جذب نخبگان، سرمایه و داده موفقیت چندانی کسب کنند. اما در دهههای آتی و در زمان طرح این سؤال که چه کسی اولین هوش مصنوعی عمومی را توسعه خواهد داد، تحقیقات و پژوهشها عامل تعیینکنندهای خواهند بود.

پیشنهاد ویدئو: سخنرانی علمی پروفسور هانس اوسکوغیت با موضوع ابرهوش در کنفرانس ۲۰۱۷ ظهور هوش مصنوعی

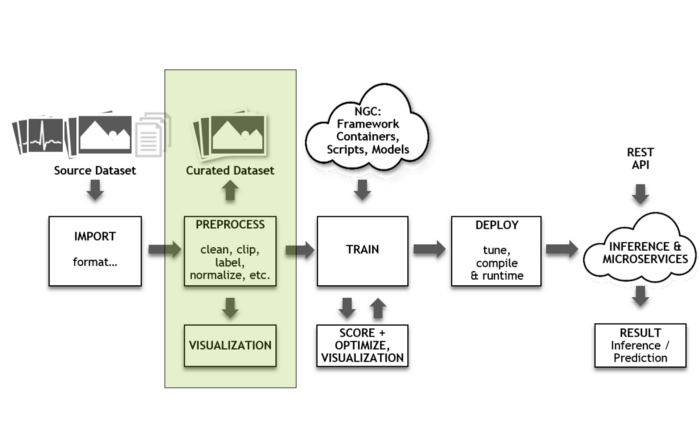

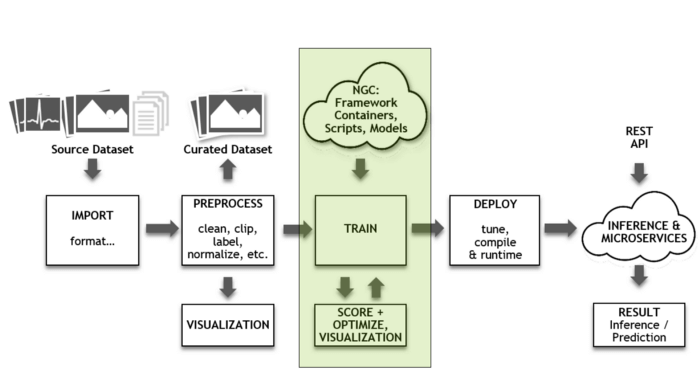

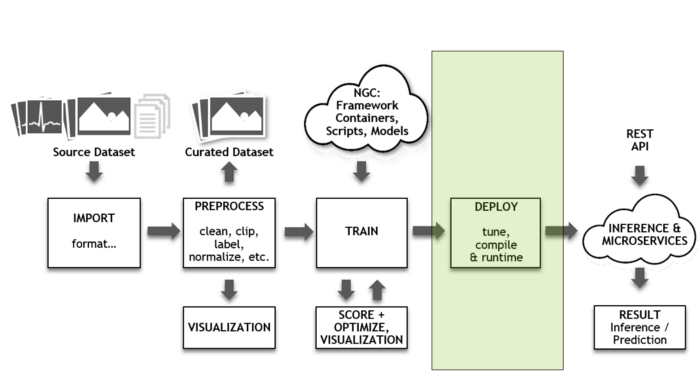

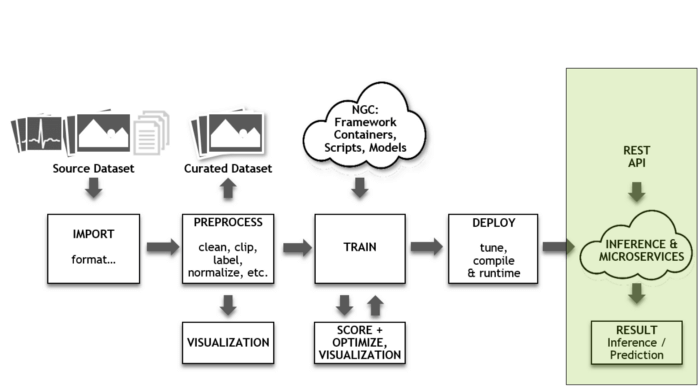

بدون وجود زیرساخت هوش مصنوعی هم وجود نخواهد داشت

در اینجا منظور از زیرساخت صرفاً امکان دسترسی به دادهها نیست. در این مقاله واژه زیرساخت توان محاسباتی و عملیاتی را نیز در بر میگیرد. پیش از این NVIDIA به خاطر تولید کارت گرافیک شناخته میشد. در حال حاضر NVIDIA یکی از تولیدکنندگان پیشگام GPUها است که به طور فزایندهای در پیادهسازی و اجرای برنامههای کاربردی هوش مصنوعی مورد استفاده قرار میگیرد. گوگل و Intel و شرکتهای زیاد دیگری به توسعه انواع و اقسام گوناگون تراشههای هوش مصنوعیمشغول هستند. در همین زمان شرکتهای مایکروسافت، AWS، گوگل، IBM نیز ظرفیت سرویسهای ابری خود را در سراسر جهان افزایش میدهند تا بتوانند پاسخگوی تقاضای رو به افزایش برای این فنآوری باشند. کشور چین تا حد زیادی بر توسعه ۵G تمرکز کرده اما اروپا در این حوزه نیز فعالیت چندانی ندارد؛ فنآوری ۵G برای برنامههای کاربردی لحظهای هوش مصنوعیو صنعت شبکهاهمیتی حیاتی دارد.

ضرورت تأمین منابع مالی هوش مصنوعی

توسعه فنآوری هوش مصنوعی هزینهبر است. تعداد پژوهشگران برتر هوش مصنوعی اندک است و سالانه حقوقی تا ۳۰۰.۰۰۰ یورو دریافت میکنند. دادهها را باید جمعآوری، ذخیره و برچسبگذاری کرد. برای توسعه مدلهای هوش مصنوعی باید زمان زیادی صرف آزمایش، خطاها و روشهای جدید کرد.

فنآوریهای هوش مصنوعی به داده نیاز دارند و باید آنها را آموزش دارد. شرکتها، کسبوکارهای نوپا، سرمایهگذاران و دولتها هزینههای توسعه فنآوریهای هوش مصنوعی را پرداخت میکنند. کشور چین با آگاهی به این موضوع در حال سرمایهگذاری بیش از ۱۳۰ میلیارد یورو در بازار هوش مصنوعی چین است. استانهایی از جمله پکن، شانگهای و تیانجیندر حال سرمایهگذاری میلیاردها یورو در صنعت هوش مصنوعی بومی خود هستند. در ایالات متحده نیز شرکتهای گوگل، IBM، مایکروسافت، آمازون، فیسبوک و اَپل تا سال ۲۰۱۵ بیش از ۵۵ میلیارد دلار در این حوزه سرمایهگذاری کردهاند. بدون پول هوش مصنوعی هم وجود نخواهد داشت. و اروپا در این زمینه نیز از سایر کشورها عقب مانده و مبالغ کمی در این حوزه سرمایهگذاری میکند.

در سال ۲۰۱۸ پارلمان فدرال آلمان، بوندستاگ، منابع مالی فنآوری هوش مصنوعی را تا سقف ۵۰۰.۰۰۰ یورو تأمین کرد. قرار است بوندستاگ ۵۰۰ یک سرمایهگذاری میلیون یورویی دیگر در این حوزه انجام دهد اما هنوز این سرمایهگذاری را انجام نداده است. با سرمایهگذاری این مبالغ ناچیز نمیتوان به موفقیت چندانی دست یافت.

در همین زمان چین منابع مالی ۴۰۰ کُرسی جدید برای هوش مصنوعی را تأمین کرده است. اما تا به امروز ۱۰۰ کُرسی استادی جدیدی که در استراتژی هوش مصنوعی آلمان به آن اشاره شده اقدام و فعالیت خاصی انجام ندادهاند. اما بریتانیای کبیر ، علیرغم برگزیت، رویکرد متفاوتی با سایر بخشهای اروپا در پیش گرفته است. در بریتانای کبیر سرمایهگذاریهای بیشتری در کسبوکارهای نوپا و دانشگاههای فعال در زمینه هوش مصنوعی انجام میشود.

برای کسب اطلاعات بیشتر در زمینه جایگاه و موقعیت کنونی هوش مصنوعی میتوانید گزارش ۲۰۱۹ جایگاه هوش مصنوعی را مطالعه کنید و ویدئوی سخنرانی من در کنفرانس ظهور هوش مصنوعی را تماشا کنید.

جایگاه اروپا در مسابقه تسلیحات هوش مصنوعی

همانگونه که پیش از این نیز گفتیم، در حال حاضر اروپا در حوزه هوش مصنوعی از کشورهای دیگر عقب مانده است. درحالیکه اروپا هنوز به این فکر میکند که آیا وارد این رقابت شود یا خیر، چین و ایالات متحده، فلسطین اشغالی، بریتانیا، کانادا بر سر داده، بازارها و نخبگان با یکدیگر به رقابت میپردازند. مشکلاتی که در اروپا با آن مواجه هستیم را خودمان به وجود آوردهایم، این مشکلات در نتیجه عدم جاهطلبی، بینش ناکافی ما شکل گرفتهاند.

علاوه بر این در اروپا مبالغ کمی به آموزش اختصاص داده میشود. بودجه کافی به مدارس و دانشگاهها و همچنین دانشآموزان و دانشجویان تعلق نمیگیرد. به بیانی دیگر کودکان اروپایی به حد کافی در زمینه مهارتهای دیجیتالی آموزش نمیبینند. دانشآموزان اروپایی به ندرت موضوعات و دروس مرتبط با هوش مصنوعی را انتخاب میکنند. علاوه بر تمامی مواردی که به آنها اشاره شد امکان آموزش مجدد برای نیروی کار هم اندک است؛ در صورتی که نیروهای کار دوباره آموزش ببینند میتوانند دانش و مهارتهای لازم برای صنعت دیجیتالی را فرا بگیرند.

نتایج حاصل از تحقیقات و پژوهشها به کندی به صنعت منتقل میشود. نتایج حاصل از تحقیقات و پژوهشها یا نادیده گرفته میشوند و یا بروکراسیهای مربوط به انتقال مالکیت فکری به ویژه برای شرکتهای نوپا و شرکتهای اسپینآففرایند دشواری است.

منابع مالی کسبوکارهای نوپای هوش مصنوعی در اروپا به اندازه کافی تأمین نمیشود. شرکتها باید محصولاتی مانند دوچرخه و یا اسکوتر برقی بفروشند تا بتوانند سرمایهگذاریهای سرمایهگذاران را جذب کنند اما اگر بخواهند در حوزه فنآوری فعالیت کنند شانس کمی برای جذب سرمایهگذاریها دارند. به عبارت دیگر هر چه محصول پیچیدهتر باشد ، امکان جذب سرمایه هم کمتر است. از سوی دیگر هر چه مدل کسبوکار سادهتر باشد، سرمایهگذاران بیشتر به سوی آن جذب میشوند و سرمایههای خود را در آن سرمایهگذاری میکنند.

هرچند بسیاری از نخبگان آسیایی و آمریکایی تمایل دارند در اروپا مشغول به کار شوند اما به لحاظ بروکراسی عملی اشتغال آنها کار دشواری است. از زمان هجوم موجهای پناهندگان به اروپا ادارات دچار آشفتگی شدهاند. تقریباً غیر ممکن است که بتوان توسعهدهندگان هوش مصنوعی ایرانی، روسی یا چینی را استخدام کرد. در حال حاضر امکان عدم پذیرش نخبگان در اروپا بیشتر از پذیرش آنها است.

علاوه بر این اروپا فاقد استراتژی هوش مصنوعی است. کشورهایی همچون فنلاند، سوئد، هلند و یا فرانسه استراتژیهای هوش مصنوعی خود را تدوین کردهاند و جاهطلبی لازم را هم دارند.

زمانی که در سال ۲۰۱۸ در کمیسیون اروپابودم یکی از پژوهشگران بلغاری گفت که خوش میشود اگر کشورش فقط یک طرح برای هوش مصنوعی داشته باشد. به گفته این پژوهشگر وضعیت تمامی بخشهای اروپا بدتر از اروپای غربی است.

من نمیگویم که سیاستمداران باید تمامی مشکلات را حل کنند. شرکتهای کماکان باید به ساخت محصولات ادامه دهند، بنیانگذاران باید کسبوکارهای نوپا تأسیس کنند، صندوقهای سرمایهگذاری خطرپذیر باید منابع مالی کسبوکارهای نوپا را تأمین کنند و پژوهشگران هم باید وقت خود را صرف تحقیق و پژوهش کنند.

اما سیاستمداران میتوانند یک استراتژی مشخص تدوین کنند و از این طریق از ما حمایت و پشتیبانی کنند. سیاستمداران به جای آنکه مانع چارچوبهای قانونی و نظارتی شوند باید چارچوبهای نظارتی و قانون تنظیم کنند. دولت باید در سرمایهگذاران انگیزه سرمایهگذاری ایجاد کند و الگوی آنها باشد. علاوه بر این سیاستمداران باید از آموزش دانشآموزان، دانشجویان و تحصیلات باکیفیت حمایت و پشتیبانی کنند.

در مقالات راجع به مواردی که به آنها اشاره شد بحث و گفت و گو شده (استراتژی هوش مصنوعی دولت فدرال آلمان) اما در عمل کاری از پیش نمیبرند.

چالشهای جهانی برای بشریت

اروپا بخشی از جهان را تشکیل میدهد و باید با مراتب قدرت جهان سازگار شود. از این روی صنعت رو به رشد هوش مصنوعی با چالشهای زیادی مواجه میشود. اولین چالشی که هوش مصنوعی با آن مواجه است مسئله عدم افشا و حفاظت از اطلاعات است. چه استانداردهایی باید اجرا شود؟ در حال حاضر اروپا استانداردهای مشخصی تنظیم و تدوین کرده است که بر مبنای آنها شرکتها باید فنآوریهای هوش مصنوعی را خارج از اتحادیه اروپا توسعه دهند.

آیا در آینده قانون عدم افشای اطلاعات را کنار میگذاریم و همچون چین رویکرد آزادنهای نسبت به دادهها خواهیم داشت؟ یا اروپا رویکرد میانه ای در پیش خواهد گرفت؟

کنترل و نظارت بر فناوری هوش مصنوعی ضروری است

علاوه بر این تمامی دولتها باید فناوری هوش مصنوعی را تحت کنترل و نظارت داشته باشند و قوانینی برای این حوزه وضع کنند. فنآوری هوش مصنوعی به طور فزایندهای رسانهها، صنایع، آموزش، امنیت، صنایع نظامی و بازارهای مالی را تحت تأثیر قرار میدهد. به همین دلیل لازم است قوانین و مقرراتی برای چگونگی کنترل و نظارت بر هوش مصنوعی ( و شرکتهایی که آن را طراحی میکنند ) وضع شود.

برای مثال یک شرکت چینی موسوم به Squirrel AI به میلیونها دانشآموز کمک کرد تا محتوای آموزشی فردی و شخصی تولید کنند که مطابق با مهارتها و سرعت یادگیری آنها است. اما در اروپا چه کسی فنآوریهای هوش مصنوعی را به لحاظ محتوا و موضوع کنترل و نظارت میکند؟ به عقیده من وزارتهای آموزش بومی در جایگاهی نیستند که بتوانند این کار را انجام دهند. به همین دلیل مقامات مسئل باید متخصصین لازم را استخدام کنند، مفاهیم را تدوین کنند و آنها را به اجرا درآورند. این کار زمانبر است باید پیش از آنکه دیر شود انجام شود.

لزوم تدوین چارچوب اخلاقی برای فناوری هوش مصنوعی

فناوری هوش مصنوعی به طور مداوم در حال تصمیمگیری است و تقریباً در هر تصمیمگیری باید مسائل اخلاقی را در نظر گرفت. اخلاقیات و اصول و ضوابط اخلاقی هوش مصنوعی از اجزای جدایی ناپذیر تحقیقات و پژوهشها و بهکار گیری فنآوری هوش مصنوعی هستند.

فناوری هوش مصنوعی میتواند مانع و یا باعث تشدید تعصب، نژادپرستی، فساد و تبعیض جنسی شود. به همین دلیل لزوم تدوین و تنظیم یک چارچوب اخلاقی برای فنآوری هوش مصنوعی به شدت احساس میشود. در سطوح بالاتر، تمامی مناطق فرهنگی ناگزیر به استفاده از آن هستند. به چه نوع فناوری هوش مصنوعی نیاز داریم؟ این فناوریها چه ارزشهایی باید برای ما به ارمغان میآورند؟

هر چه زودتر باید راجع به اصول و ضوابط اخلاقی هوش مصنوعی تصمیمگیری کنیم. در حال حاضر، فنآوریهای هوش مصنوعی در حال توسعه داده میشوند که هیچگونه نظارت اخلاقی بر آنها صورت نمیگیرد. تصمیمگیری راجع به اینکه در آینده ماشینها چگونه عمل کنند به توسعهدهندگان بستگی دارد. اما جامعه هم باید نسبت به درست و غلط بودن امور اینچنین سختگیری داشته باشد.

از این روی تمامی ملتها، سیستمهای دولتی و گروههای نژادی باید راجع به چارچوبهای اخلاقی فنآوریهای هوش مصنوعی خود به بحث و گفتوگو بنشینند.

شرکتها هم باید همین رویه را در پیش بگیرند. تمامی شرکتها همانگونه که یک متخصص عدم افشا و حفاظت از اطلاعات و متخصص داده دارند باید یک متخصص علم اخلاق هوش مصنوعی را هم به استخدام خود در آورند. وظیفه متخصص علوم اخلاقی هوش مصنوعی این است که از شود که مطمئین شود دادهها عاری از هر گونه سوگیری هستند و تبعیض ایجاد نمیکنند.

ظهور فناوریهای پیشرفته هوش مصنوعی

علاوه بر این لازم است مسئله رشد و پرورش هوش و همچنین تأثیر فناوری هوش مصنوعی را نیز مد نظر قرار دهیم. اخیراً مایکروسافت یک میلیارد دلار دیگر برای تحیقیق و پژوهش در زمینه هوش مصنوعی عمومی در اختیار OpenAI گذاشته است، علاوه بر این ایلان ماسکنیز یک میلیارد دلار دیگر به این طرح اختصاص داده است. ماسک، زاکربرگ، هاوکینگو گیتسراجع به هوش مصنوعی اخطار دادهاند. در حال حاضر ممکن است سیریاحمق به نظر برسد اما تا ده سال آینده هوشمندی آن بیشتر از انسانها خواهد بود.

هوش مصنوعی هر روز باهوشتر، سریعتر، تواناتر و داناتر میشود. برخلاف ماهیت زیستشناختی انسانها، فنآوریهای هوش مصنوعی هیچ محدودیتی ندارند. در نتیجه هر روز باید عمیقاً راجع به هوش مصنوعی عمومی، هوش مصنوعی قویو هوش مصنوعی سوپرفکر کنیم. علاوه بر این موضوعاتی همچون رابط های عصبی و سیستم عاملهای انسانی را نیز باید مد نظر قرار دهیم.

پیشنهاد ویدئو: سخنرانی علمی دکتر لیندراجع به هوش مصنوعی قوی در کنفرانس ۲۰۱۹ ظهور هوش مصنوعی.

ماشینها به انرژی نیاز دارند

یکی دیگر از چالشهای جهانی فناوری هوش مصنوعی نیاز ماشینها به انرژی است. ذهن انسانها به اندازه یک لامپ به الکتریسیته نیاز دارد، اما نرمافزارهای کاربردی هوش مصنوعی انرژی بر هستند. در نتیجه اگر میخواهیم در زمینه فناوری رشد و پیشرفت کنیم، باید مشکلات کمبود انرژی را برطرف کنیم. در غیر این صورت همه مردم نمیتوانند مدت زمان زیادی عمر کنند و زندگی سالمی داشته باشند.

جامعهای بدون کار؟

علاوه بر این ما به عنوان یک جامعه باید راجع به تأثیرات فناوریهای هوش مصنوعی بر مشاغلمان بحث و گفتوگو کنیم. ما به ویژه آلمانیها میترسیم که هوش مصنوعی جایگزین شغلهای ما بشود.

من شخصاً خوشحال میشوم اگر هوش مصنوعی بتواند به جای من کار کند. اما هوش مصنوعی شغلهای شما را از رده خارج نمیکند. طبق برآوردهای من و با توجه به اینکه ماشینها سریعتر هستند و هزینه استفاده از آنها ارزانتر است تا ۲ سال آینده ۵۰ درصد از مشاغل انسانها را ماشینهای انجام خواهند دارد.

در همان حال که توسعه و پیشرفت موضوع مثبت است چالش هم است. مشاغل جدید بسیاری به وجود خواهد آمد که امروزه حتی فکر کردن به چنین مشاغلی برای ما دشوار است. این مشاغل شامل مربیهای مهدکودک هوش مصنوعی، تعلیمدهندگان هوش مصنوعی، متخصصین علوم اخلاق هوش مصنوعی و کنترلکنندگان هوش مصنوعی میشود.

از این روی باید راجع به چگونگی بازآموزی افرادی که امروز مشاغلی برعهده دارند و در آینده ماشینها جایگزین مشاغل آنها میشوند تعمق کنیم. این بازآموزی بزرگترین بازآموزی نیروهای کار در سراسر تاریخ انسانها خواهد بود. برخی از افراد در مقابل بازآموزی مقاومت خواهند کرد، چه اتفاقی برای این افراد خواهد افتاد؟

برخی از آنها آزادی در پیش میگیرند و زندگیهایشان را مجدداً طراحی میکنند. امیدوارم در آینده زندگی به معنای کار کردن نباشد بلکه زندگی لذت بردن از زندگی باشد. امیداورم در آینده به مرحله ای برسیم که مردم برای اینکه که میخواهند کار کنند نه برای اینکه مجبور هستند. بگذارید ماشینهای کارهایی را انجام دهند که کسی نمیخواهد سراغ آنها برود. و در نهایت به افرادی که فعالیتهای اجتماعی مهمی از جمله رشد و پرورش کودکان، آموزش دانشآموزان و پرستاری از سالمندان را انجام میدهند حقوق بیشتری پرداخت کنیم.

چگونگی توزیع ثروت

احتمالاً یکی از چالشهایی که با آن مواجه میشویم چگونگی توزیع ثروت است. اگر شرکتها برای رسیدن به همان میزان بهرهوری به نیروی کار کمتری نیاز داشته باشند سود آنها ها افزایش پیدا میکند. اما معمولاً شرکتها در مالکیت خانوادهها و صندوقهای مشخصیی هستند. امروزه ۴۰ درصد از تمامی شرکتهای سهامی عام ایالات متحده در مالکیت چهار صندوق بزرگ هستند. در نتیجه این روند افراد ثروتمند رو به روز ثروتمندتر میشوند. بخش کوچکی از این ثروت به بخش اداری و اجرایی ( وکلا، بانکدارها، کارآفرینان، سرمایهگذاران) میرسد و مقدار ناچیزی برای ۹۹ درصد باقیمانده جمعیت باقی میماند.

پیشنهاد کتاب: «سرمایه در قرن بیست و یکم» اثر توماس پیکتی.

جنگ داخلی یا زندگی آرام و بیدغدغه؟

با روی کارآمدن فناوری هوش مصنوعی این روند تشدید میشود. این فکر که تا ۳۰ سال آینده ۱۰۰ نفر کنترل جهان خواهند گرفت مرا نگران میکند. در اینجا منظور از کنترل بر جهان فقط پول و ثروت نیست بلکه دسترسی به کدهای ماشین و در نتیجه کنترل بر اقتصاد جهانی، صنایع نظامی و اطلاعات است. اگر اکثر مردم اهمیت و کارایی کنونیشان را برای سیستم به ویژه در حوزه اشتغال و مصرف از دست بدهند، چه اتفاقی میافتاد؟ آیا ایده Club of Rome به حقیقت میپیوندد و تعدادمان را (علیرغم میل باطنی) به ۵۰۰ میلیون نفر کاهش میدهیم؟

فناوری هوش مصنوعی این کار را ممکن میسازد. در نتیجه برای جلوگیری از وقوع جنگ داخلی، باید ثروت را پیشاپیش توزیع کرد. در هر حال بخشی از این ثروت باعث میشود که دیگر کسی از فقر و گرسنگی و بیخانمانی رنج نبرد. رویکردها و ایدههای زیادی وجود دارد. در آینده زمان بیشتری را صرف بحث و گفتوگو راجع به آنها از جمله درآمد و نقدینگی میکنیم.

و باید مطمئن شویم در دنیایی زندگی میکنیم که هوش مصنوعی در خدمت تمامی انسانها است.

منبع: hooshio.com