اگر فکر میکنید که نقش هوش مصنوعی و یادگیری ماشین در فروشگاه های آنلاین هنوز در مراحل اولیه خود است، به نحوه عملکرد شرکت آمازون نگاه کنید. به یاد دارید که چگونه این پلتفرم آنچه را که ممکن است دوست داشته باشید بخرید به شما پیشنهاد میدهد؟ یا چگونه آنچه را که آخرین بار خریدهاید به یاد میآورد و به شما یادآوری میکند؟

این جادوی هوش مصنوعی است

مانند آمازون، وبسایتهای تجارت الکترونیکی بسیاری وجود دارند که با استفاده از پتانسیل الگوریتمهای یادگیری ماشین در فروشگاه های آنلاین قدرت این فناوری نوین را در تجارت الکترونیکی نشان میدهند. تحقیقات Tractica ادعا میکند که ارزش هوش مصنوعی در تجارت الکترونیکی تا سال ۲۰۲۵ به ۳۶.۸ میلیارد دلار میرسد. واضح است که هوش مصنوعی تجارت الکترونیکی در حال پیشرفت است و این روند در سال ۲۰۲۱ نیز ادامه خواهد داشت. در ابتدا بیایید به یک تعریف ساده یادگیری ماشین، انواع مختلف آن و کاربردهای متنوع آن در بخش تجارت الکترونیکی نگاهی بیندازیم.

یادگیری ماشین چیست؟

یادگیری ماشین زیرمجموعهای از هوش مصنوعی است. اگرچه به نظر میرسد این یک مفهوم پیچیده است اما یادگیری ماشین، فرآیند آموزش یک برنامه یا الگوریتم رایانه برای سازگاری مداوم و “یادگیری” از محیط است تا بتواند وظیفه محول شده را بهخوبی انجام دهد و بهبود ببخشد. یادگیری ماشین برای دستیابی به این هدف از مدلهای ریاضی استفاده میشود.

انواع الگوریتمهای یادگیری ماشین

بهطورمعمول، سه نوع الگوریتم یادگیری ماشین وجود دارد که میتواند بر اساس وظیفه دادهشده و محیط یادگیری مورد استفاده قرار گیرد:

الگوریتمهای یادگیری بدون نظارت

الگوریتم یادگیری بدون نظارت، الگوریتمی مبتنی بر داده است که از برچسب استفاده نمیکند. وظیفه اصلی این الگوریتم این است که حجم عظیمی از دادهها را گروهبندی، خوشهبندی و یا سازماندهی کند تا یک انسان (یا یک الگوریتم هوشمند دیگر) بتواند آن را درک کند. این ویژگی الگوریتمهای یادگیری بدون نظارت بهتنهایی میتواند باعث افزایش بهرهوری برای صنایع و بنگاههای اقتصادی در سراسر طیف شود.

الگوریتمهای یادگیری با نظارت

الگوریتم یادگیری با نظارت یک الگوریتم وظیفه-محور است و یکی از پرکاربردترین مقولههای یادگیری ماشین است زیرا اجرای آن ساده و کاربرد آن آسان است. شما بهاحتمال زیاد با این نوع یادگیری سروکار زیادی خواهید داشت، زیرا در بسیاری از کاربردهایی که در ادامه نام برده میشوند حضوری فعال دارد.

نحوه کار الگوریتم یادگیری تحت نظارت به شرح زیر است:

شما دادههایی را که باید وارد کنید با یک “برچسب” روی آن ایجاد میکنید.

سپس این جفت نمونه برچسب را به الگوریتم یادگیری تغذیه میکنید.

الگوریتم در جهت پیشبینی برچسب برای هر مثال تلاش میکند.

شما در رابطه با اینکه الگوریتم پاسخ درست را پیشبینی کرده است (یا نه) بازخورد ارائه میدهید.

با گذشت زمان، هر چه تعداد بیشتری از نمونهها را تغذیه کنید، الگوریتم

“خود یاد میگیرد” تا زمانی که بتواند بهدرستی وظیفه محوله را مشاهده،

پیشبینی و تکمیل کند.

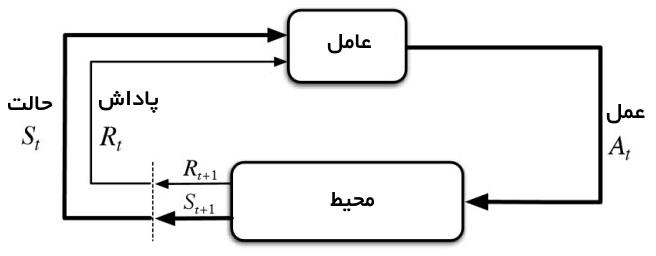

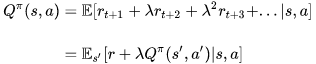

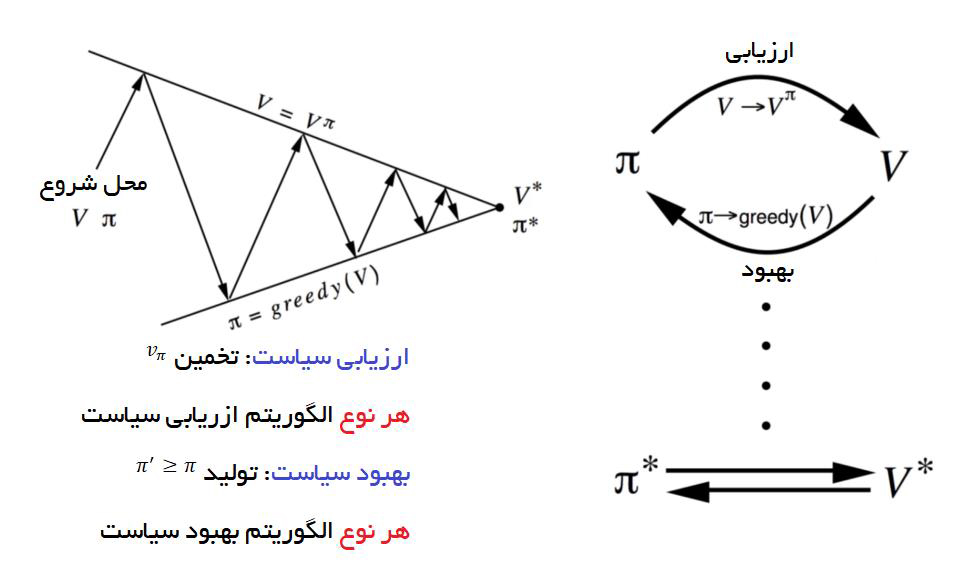

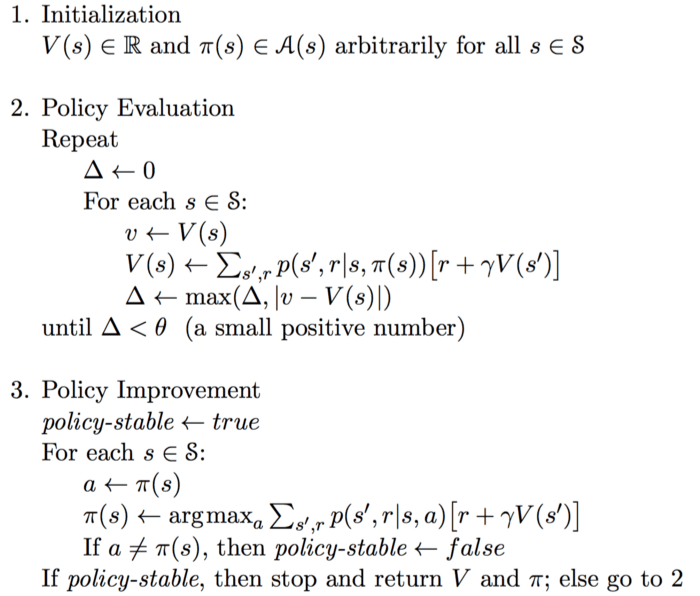

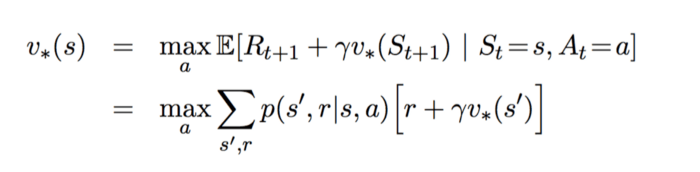

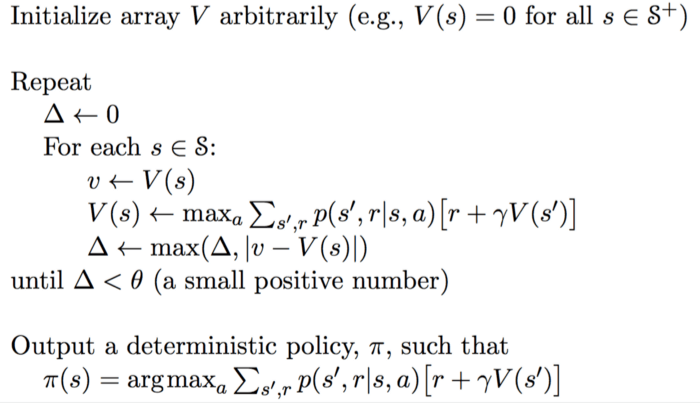

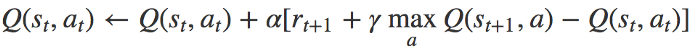

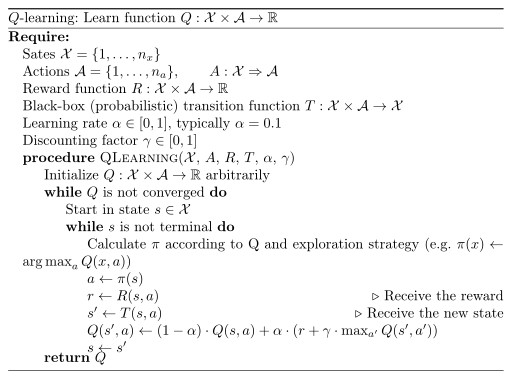

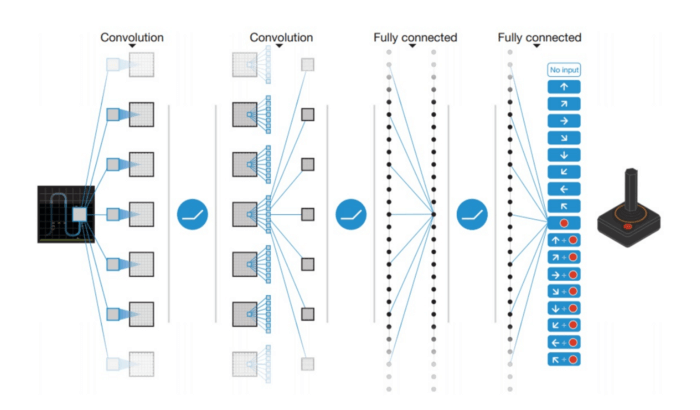

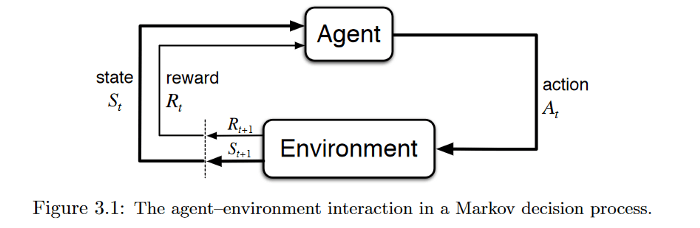

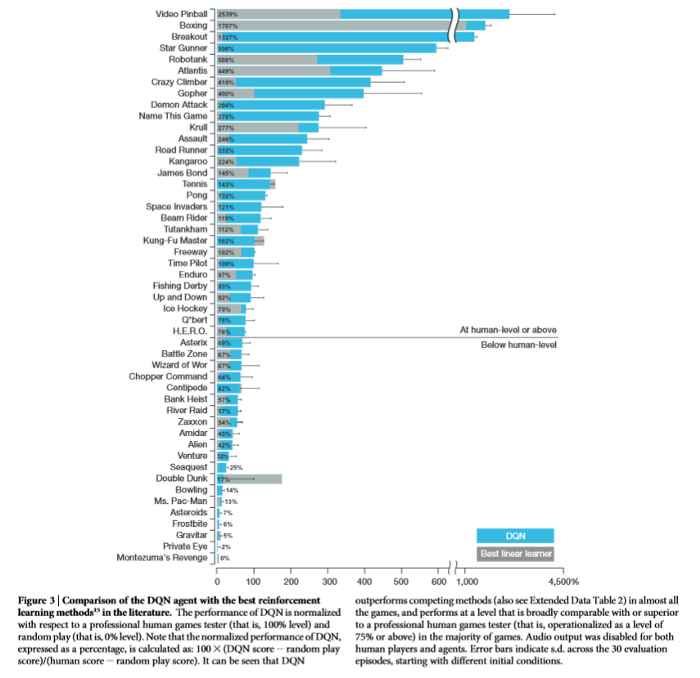

الگوریتمهای یادگیری تقویتی

به بیان ساده ، یادگیری تقویتی یک الگوریتم یادگیری رفتار-محور است که از طریق اشتباهات مکرر و آزمونوخطا میآموزد. درواقع این شبیه زمانی است که والدین تلاش میکنند از طریق تقویت مثبت یا منفی چیزی را به کودک آموزش دهند. در اینجا نحوه کار الگوریتم یادگیری تقویتی را مشاهده میکنید.

شما یک سیگنال مثبت به الگوریتمی اختصاص میدهید که آن را با رفتار خوب مرتبط میکند.

به همین ترتیب، شما یک سیگنال منفی برای رفتارهای بد اختصاص میدهید.

با گذشت زمان، الگوریتم یاد میگیرد رفتارهای خوب را بیشتر کند و رفتارهای

بد را کاهش دهد. این تقویت ترجیح رفتارهای خوب بر رفتارهای بد باعث میشود

الگوریتم یاد بگیرد و اشتباهات کمتری داشته باشد.

اکنون که شما درک سادهای از الگوریتمهای یادگیری ماشین و انواع اساسی آن را دارید. حال بیایید بفهمیم که از این الگوریتمها چگونه استفاده میشود تا تجربه تجارت الکترونیکی بهبود بخشیده شود.

۱-شخصیسازی محتوا و پیشنهاد محصول

“۸۰٪ از خریداران بهطور فعال از مارکی خرید میکنند که تجربیات شخصی را ارائه میدهد.”

بیاید با این موضوع روبرو شویم. آگاهانه یا ناآگاهانه، همه ما با شخصیسازی محتوا در وبسایتهای تجارت الکترونیکی به اشکال مختلف روبرو شدهایم

پیشنهاد محصول: اگر هنوز هم برای بهکارگیری سیستم های توصیه گر مردد هستید، به آمازون فکر کنید که ادعا میکند ابزار پیشنهاد دهنده این شرکت دلیل ۳۵٪ از فروش این شرکت است! این ابزار یادگیری ماشین بسیار کاربردی است زیرا الگوریتم قادر است الگوهای کاربر را بر اساس رفتار مشتری و خرید قبلی پیشبینی کند.

پیشنهادهای صفحه اصلی شخصی شده: هر محتوایی بر اساس نیازها و تنظیمات کاربر سفارشی میشود. همانطور که قبلاً ذکر شد، هیچکس بهتر از آمازون شخصیسازی نمیکند.

پیشنهاد محصولات تخفیفدار: یادگیری ماشینی میتواند بهترین تخفیفها و پیشنهادها را پیشبینی کند و به مشتری ارائه دهد و به همین دلیل باعث فروش و همچنین رضایت کاربر میشود.

ایمیلهای ارسالی به کاربر: یادگیری ماشینی به شما امکان میدهد مناسبترین زمان برای ارسال خبرنامههای ایمیل سفارشی یا ایمیلهای مرتبط با سفارش را با پیشبینی اینکه در چه ساعت و روزی از هفته به احتمال زیاد فرد ایمیل دریافتی را باز کند، متوجه شوید. این بهینهسازی مستقیماً بر نرخ باز شدن، نرخ کلیک و غیره تأثیر میگذارد

تغییر در محتوای پویا: این شامل فیلتر کردن تصاویر، محصولات و غیره و ارسال هشدارها و پیامهای سفارشی برای هر خریدار است. به عنوان مثال ، از ویژگی “Fit Search” Fit Connect استفاده کنید که فیلترهای مبتنی بر تناسب را ارائه میدهد تا محصولات موجود در اندازههای مناسب به نمایش بگذارد.

آنچه مهم است که توجه داشته باشید این است که این “شخصیسازی بیش از حد” بر اساس نقاط کلیدی دادههای مشتری و توجه به خریدهای گذشته، سابقه مرورگران، تبلیغات پولی، اطلاعات جمعیتشناختی، تنظیمات شخصی، فعالیت رسانههای اجتماعی و سایر موارد است. اینجاست که الگوریتمهای یادگیری ماشین به کار میآیند. آنها از انواع دادههای مشتریمحوری استفاده میکنند، طوری که احساس میشود وبسایت واقعاً کاربر را درک میکند و میتواند ذهن آنها را بخواند!

اقدام اصلی: برای ارائه سفارشیسازی درلحظه، شما باید در یادگیری ماشین بهطور صحیح سرمایهگذاری کنید تا بتوانید دادههای کاربر را درک و اعمال کنید و عناصر مهم مانند زبان، مکان، ارز، معاملات و تخفیفها و موارد دیگر را شخصیسازی کنید. همچنین یادگیری ماشین میتواند رفتار خرید را بارها و بارها هوشمندانه تجزیهوتحلیل کند و درنهایت محصولی را پیشنهاد دهد که مشتریان شما حتی نمیدانستند که به آن نیاز داشتند.

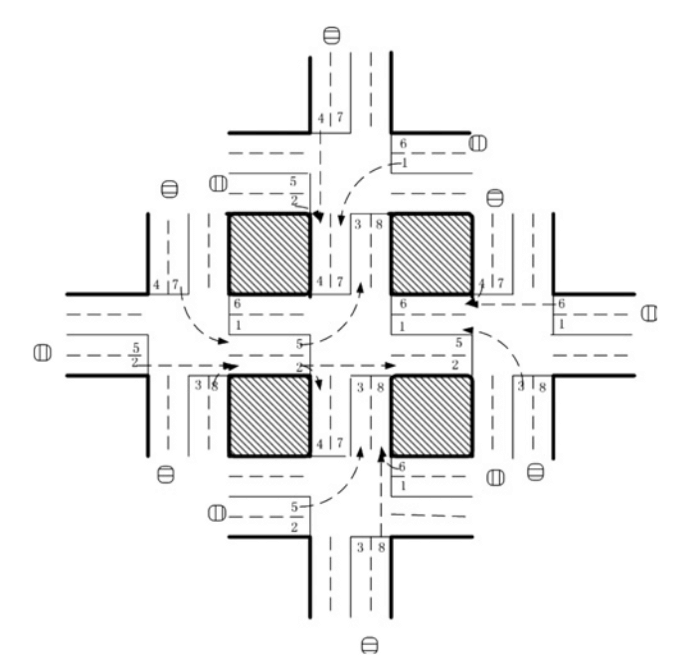

۲- بهینهسازی قیمتگذاری

بهینهسازی قیمت، کلید ایجاد مجموعهای وفادار از مشتریانی است که برای همیشه در جستجوی “معامله بهتر” هستند. اگر وبسایت شما قیمت کالاها را بر اساس فاکتورهایی ازجمله قیمت سایتهای رقیب، میزان تقاضا، ساعات مختلف روز، انواع مشتری و غیره بهینه نکند شما مشتریها را هر دقیقه از دست خواهید داد.

در همین راستا، فناوری یادگیری ماشینی میتواند یاریکننده شما شود و قیمتها را بر اساس عوامل مختلفی که در بالا ذکر شد بلافاصله تغییر دهد.

نگاهی به فناوری قیمتگذاری مبتنی بر هوش مصنوعی Feedvisor بیندازید که به شما امکان میدهد قیمتها را بهینه کنید و در قیمتگذاریهای پویا شرکت کنید.

نکته کلیدی: یک سیستم قیمتگذاری پویا ، که توسط الگوریتمهای یادگیری ماشین هدایت میشود ، فروش محصولات سازگار و ارگانیک را هر بار پایهریزی میکند. بهعلاوه ، به مدیران قیمت اجازه میدهد تا از سرعت و دقت برای تصمیمات مربوط به قیمتگذاری محصولات استفاده کنند

۳- آزمون A/B با یادگیری ماشین

پیادهسازی آزمون A/B در یک وبسایت تجارت الکترونیکی یک کار نسبتاً سخت است. اینجاست که یادگیری ماشینی واقعاً میدرخشد. ابزارهای تخصصی یادگیری ماشین مانند Nosto به شما امکان میدهد آزمون A / B / n ، تقسیم و چند متغیره را در پارامترهای مختلف مانند پیشنهاد محصول، محتوا، طبقهبندی کالاها و غیره اجرا کنید.

در اینجا تجزیهوتحلیل سریع انواع آزمون A / B که میتواند بدون زحمت و با کارایی بیشتر انجام شود را مشاهده میکنید.

این میتواند روند آزمایش A / B را بهصورت خودکار انجام دهد و ویژگیهای ایدئال را نشان دهد که میتواند فروش و یا رضایت مشتری را افزایش دهد. به عنوان مثال، این الگوریتمها میتوانند رفتار کاربر را در انواع مختلف آزمون A / B تجزیهوتحلیل کنند و کارهایی همچون برجستهتر نشان دادن دکمه call to action یا درج تصویر در بنر صفحه اصلی را پیشنهاد دهند.

این میتواند بهطور خودکار مشتریان را با استفاده از مدلهای یادگیری ماشین بدون نظارت و بر اساس ویژگیهای متنوعی همچون متغیرهای جمعیت شناختی و ترجیحات کاربران به گروههای مختلف دستهبندی کند.

نکته کلیدی: استفاده از الگوریتمهای خودآموز یادگیری ماشین برای آزمون A / B سیستمعامل یا محصولتان به شما امکان میدهد گزینههای “بهینه” را بهسرعت و با دقت پیدا کنید. این موضوع ازنظر مالی و عملیاتی منطقی است زیرا شما نیازی به سرمایهگذاری منابع خود در کارهای تکراری و خستهکننده ندارید زیرا یادگیری ماشین میتواند بهخوبی از پس آن بربیاید.

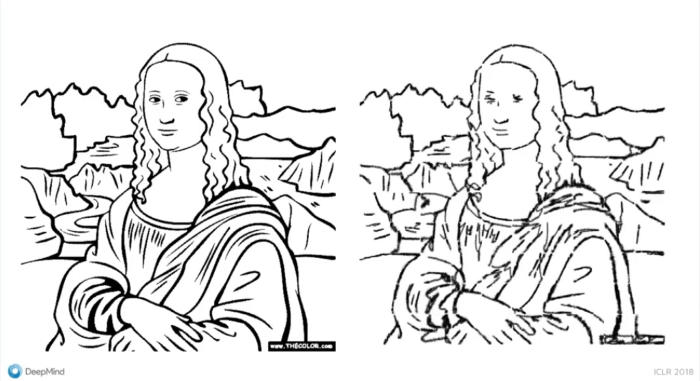

۴-پردازش تصویر

مدلهای یادگیری ماشین، اساس سیستمهای شناسایی تصویر را تشکیل میدهند که به شما امکان میدهد قابلیتهای جستجوی مشتریمدارانه بیشتری را ارائه دهید. این سیستم چگونه کار میکند؟

فرض کنید مشتری شما به دنبال خرید آنلاین کالایی است. آنها بعد از جستجو، چندین نتیجه نامربوط میبینند و تصمیم میگیرند سایت را ترک کنند. این جایی است که یادگیری ماشینی میتواند به شما کمک کند زیرا میتواند عناصر اصلی تصاویر مانند اشیا، افراد، محتوا و غیره را شناسایی کرده و گزینههای مربوطه را ارائه دهد، درنتیجه بر رفتار مشتری تأثیر مثبت میگذارد.

ویژگی جستجوی بصری سایت پینترست مورد جالبی است که به کاربر اجازه میدهد عکسهایی را که از طریق دوربین تلفن خود گرفته است جستجو کند. سپس این پلتفرم پینهای قابلخرید را در نتایج جستجوی بصری نمایش میدهد.

برای قابلیتهای جستجوی بصری زمینهای، باید یک ابزار تکنولوژی پردازش تصویر قدرتمند که مبتنی بر یادگیری ماشین است در اختیار داشته باشید؛ ابزاری که میتواند با عکسهای مشتری شما مطابقت داشته باشد و پیشنهادهای مشابه محصول را بر اساس ترجیحات مشتری ارائه دهد. این پایان کار نیست. دادههای کاربر را میتوان با توجه به مقولههای مختلف همچون رنگ موردعلاقه، انتخاب برند، رفتار شبکههای اجتماعی و غیره تقسیمبندی کرد.

نکته کلیدی: یادگیری ماشین میتواند بهطور خودکار برچسبگذاری و طبقهبندی کند و همچنین با پیوست کردن برچسب به تصاویر، فیلمها، آرمها و حتی تصاویر غیرعکاسی، محتوا را جستجو کند تا تجربه جستجوی مشتری مدارانه را بهبود بخشد.

۵-محافظت در برابر تقلب

شناسایی و جلوگیری از تقلب آنلاین برای وبسایتهای تجارت الکترونیکی باید اولویت اصلی باشد. یک راه مطمئن برای ایمنسازی وبسایت شما بهکارگیری یادگیری ماشین است که برای پردازش تعداد زیادی از مشتریان ثابت با سرعت بالا و جلوگیری از معاملات آنلاین جعلی قبل از وقوع آنها آموزش دیدهاند.

اساساً، اگر به نظر برسد معاملهای مشکوک در حال وقوع است بهطور مثال پرداخت از دستگاه تأیید نشده انجام میشود یا معامله در ساعتهای غیرمعمول انجام شود، سیستم میتواند آن را بهعنوان یک کلاهبرداری بالقوه نشان کند. درمجموع، یادگیری ماشین میتواند معاملات واقعی را تجزیهوتحلیل کند و “خریدهای واقعی” را شناسایی کند.

نکته کلیدی: وقتی صحبت از کلاهبرداری آنلاین میشود، کاربرد یادگیری ماشین در فروشگاه های آنلاین میتواند اقدامات امنیت سایبری شما را تقویت کند و به شما این امکان را میدهد که بهجای رویکردی واکنشی، یک رویکرد فعال اتخاذ کنید که منجر به یک تفاوت بزرگ میشود.

جمعبندی: نقش پویای یادگیری ماشین در فروشگاه های آنلاین

بر اساس گزارشهای اخیر، همهگیری کووید ۱۹ باعث شده تا ما به سمت دنیای دیجیتالیتر برویم و در این میان خرید آنلاین پیشتاز این امر است. درواقع گفته میشود که بیماری کووید ۱۹ نحوه خرید افراد را برای همیشه تغییر داده است. به همین دلیل است که وبسایتهای تجارت الکترونیک بیشازپیش نیاز به بازنگری در استراتژی تجاری خود دارند. اکنون دیگر زمان تردید در نقش هوش مصنوعی در تجارت الکترونیکی نیست. یادگیری ماشینی آینده تجارت الکترونیکی است و آینده در اینجا است.

انواع کاربردهای هوش مصنوعی در صنایع مختلف را در هوشیو بخوانید

منبع: hooshio.com